DragGAN, interaktywna AI do modyfikacji obrazu – to nie jest żadna edycja zdjęć

Grupa badaczy z Google wspólnie z zespołem z Max Planck Institute of Informatics i naukowcami z MIT CSAIL (czyli Massachusetts Institute of Technology Computer Science & Artificial Intelligence Laboratory) opublikowała pracę naukową prezentującą interaktywny model GAN (Generative Adversarial Network, czyli generatywne sieci współzawodniczące) do interaktywnej manipulacji obrazem. Efekt „wow” gwarantowany, choć z edycją zdjęć ma to niewiele wspólnego.

Celowo podkreślam olbrzymią przepaść między DragGAN, a wspieraną przez AI edycję zdjęć, jaką możemy już dziś przeprowadzić za pomocą wielu dostępnych narzędzi fotoedycyjnych, bo w istocie DragGAN tworzy nową rzeczywistość.

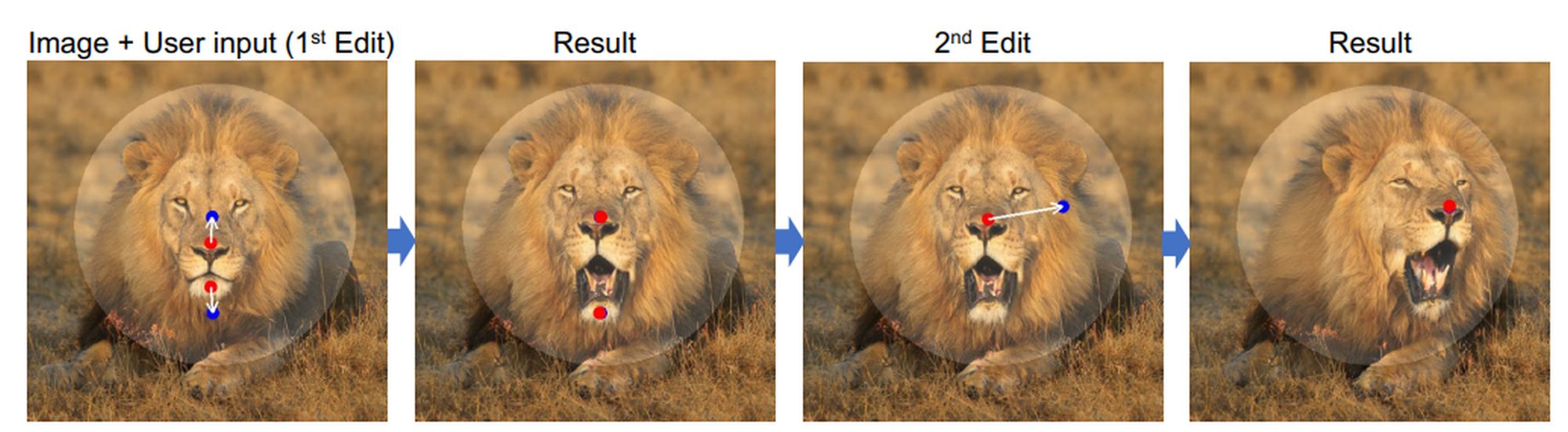

Na czym polega to rozwiązanie? Żeby nie wpadać w zawiłości współzawodniczących AI, które mają wygenerować jakiś pożądany wynik (na tym generalnie polegają GAN-y), posłużę się kadrami z wspomnianej pracy. Przykład 1:

Pierwsze zdjęcie z lewej to kadr rzeczywisty, wykonany przez fotografa. DragGAN umożliwia banalnie prostą manipulację obrazem poprzez zaznaczanie i przeciąganie aktywnych punktów obrazu wskazanych przez użytkownika. Punkty czerwone to znaczniki uchwytu, punkty niebieskie, docelowe pozycje. Opcjonalnie użytkownik może użyć maski na obrazie (to ten jaśniejszy obszar), by określić region, który może być poddany modyfikacjom, piksele poza maską mają pozostać nienaruszone w stosunku do fotografii źródłowej. W efekcie wszystkie trzy pozostałe zdjęcia lwa, to już kreacja AI, takie zdjęcia nigdy nie powstały. Lew miał zamkniętą paszczę, dwa ruchy w DragGAN i ma otwartą, jeszcze jeden ruch i łeb króla zwierząt spogląda w inną stronę. Magia. Nie mamy wątpliwości, że skrajnie zmanipulowany obraz po prawej stronie wciąż przedstawia lwa. Zobaczmy drugi przykład:

Tym razem mamy samochód. Sytuacja podobna, określamy punkty uchwytu, przeciągamy w docelowe lokalizacje i obiekt zmienia położenie. Niestety, zmienia również kształt, model na docelowej, zmanipulowanej przez DragGAN fotografii to zupełnie inne auto niż to z fotografii wejściowej, zgadza się kolor. Nie zmienia to faktu, że efekt imponuje, ale przyznacie, trudno to nazwać choćby najdalej posuniętą edycją (wbrew temu co napisali w niektórych serwisach technologicznych). Obejrzyjcie też klipy wideo umieszczone na stronach Instytutu Maxa Plancka (uprzedzam, że serwery Instytutu są bardzo obciążone, ciekawskich nie brakuje).

W naszej redakcji zaczęliśmy trochę żartować, że anegdota jak to klient przynosi do grafika zdjęcie samochodu przed domem i mówi „pan zeskanuje i odwróci dom i pokaże garaż, który za nim stoi” już nie śmieszy.