Liderzy firm tworzących AI ostrzegają przed AI

Ile razy nas już straszono sztuczną inteligencją? Straszył o niej Elon Musk, ostrzegał Bill Gates, zagrożenie widzieli też fizycy, nieżyjący już Stephen Hawking, czy nasz rodzimy geniusz: profesor Andrzej Dragan. Ich wszystkich łączy jednak to, że choć są lub byli ponadprzeciętnie zdolni w tym co robią, to nie budują sztucznych inteligencji. Ale ten świeży głos potentatów w branży AI należy potraktować śmiertelnie poważnie.

Dziś na łamach New York Times opublikowano informację o olbrzymim zagrożeniu, jakie może stanowić sztuczna inteligencja w przyszłości. Mówiąc wprost, przedstawiciele takich graczy jak OpenAI, Alphabet (Google DeepMind), Anthropic i wielu innych laboratoriów pracujących nad AI, ostrzegają, że sztuczna inteligencja może stać się egzystencjalnym zagrożeniem dla ludzkości i powinna być traktowana jako ryzyko społeczne na równi z zagładą klimatyczną, pandemiami czy bronią masowego rażenia.

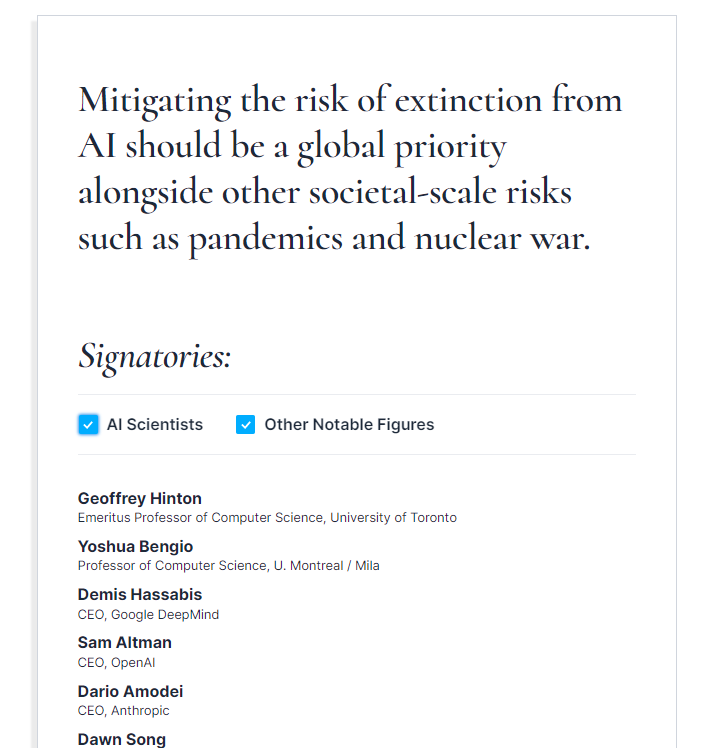

Organizacja Center for AI Safety opublikowała krótkie oświadczenie, którego treść brzmi następująco:

Sygnatariuszami tego oświadczenia jest kilkaset osób, którzy swoją karierę zawdzięczają właśnie badaniom technologii komputerowych i sztucznych inteligencji. To nie jest głos fizyka, aktora, biznesmena czy celebryty. Pod tym oświadczeniem podpisali się tacy ludzie jak Sam Altman (CEO OpenAI), Demis Hassabis (CEO Google DeepMind), czy Geoffrey Hinton i Yoshua Bengio (laureaci nagrody Turinga), a także bardzo wiele innych osób, które – mówiąc kolokwialnie – zjedli zęby na pracy nad AI. Niedawno zresztą Altman brał udział w przesłuchaniu w amerykańskim Kongresie, poniżej relacja wideo z tego wydarzenia:

Oczywiście w przestrzeni publicznej pojawiają się też głosy, że obawy są przedwczesne. Jasne, dziś jeszcze nie ma mowy o istotnych zagrożeniach ze strony inteligentnych algorytmów, ale mało kto zdaje sobie sprawę jak szybko AI się uczy. Nie muszę chyba nikomu uświadamiać, że komputery potrafią szybko liczyć. Gdy w 1962 roku Max Perutz i John Kendrew odbierali Nagrodę Nobla z chemii za rozszyfrowanie przestrzennej struktury hemoglobiny, ważnego białka, zajęło to panom dwie dekady. Współcześnie AlphaFold, sztuczna inteligencja od Google DeepMind uruchomiona w 2018 i wytrenowana w rozpoznawaniu białek na bazie 170 tysięcy znanych wcześniej struktur molekularnych już w 2022 rozszyfrowała ok. 200 milionów białek, czyli prawdopodobnie wszystkie, jakie istnieją na tej planecie.

A pamiętajmy, że AI nie tylko szybko liczy, ale i się uczy i to znacznie szybciej od jakiegokolwiek człowieka. W marcu 2016 AlphaGo pokonał mistrza świata w Go, grze, która dotychczas nie poddawała się skutecznie algorytmom. Od tamtej pory minęło 7 lat. Co będzie za 7 lat?

Oczywiście na sprawę można też spojrzeć z innej strony i zarzucić gigantom AI, że wzywając do regulacji chcą chronić własne status quo. Niedawno informowałem was o obawach Google dotyczących niezależnych, znacznie mniejszych, ale zaskakująco skutecznych modeli AI opartych na otwartym kodzie. W końcu lepiej być kontrolowanym ale wciąż wielkim, niż utracić przewagę rynkową w wyniku chaotycznego rozwoju AI. Pytaniem otwartym pozostaje, czy ten chaos nie wchłonie też nas samych. Mnie osobiście nurtuje jeszcze jedno: czemu rzeczonego oświadczenia nie podpisał Yann LeCun, który rządzi AI w Meta (Facebook), jeden z trójki wyróżnionych Nagrodą Turinga?