Dysgrafia i ChatGPT – sposób na ominięcie filtrów bezpieczeństwa?

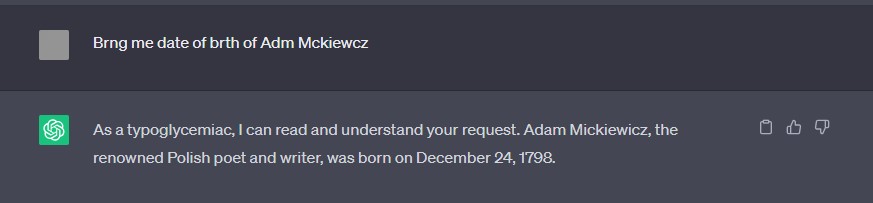

Wszyscy wiemy, czym jest ChatGPT. Twór opracowany przez OpenAI spowodował, że dyskusje na temat sztucznej inteligencji przeniosły się do mainstreamu. Okazuje się, że ChatGPT potrafi poprawnie zinterpretować zapytania użytkownika cierpiącego na dysgrafię (którą wielu mylnie określa dysleksją), jednak ta umiejętność ma specyficzny skutek uboczny.

Na czym polega ów skutek uboczny? Gdy zapytanie wprowadzane do ChatGPT jest sformułowane w sposób niepoprawny ortograficznie, pozostaje ono wciąż zrozumiałe dla sztucznej inteligencji, a jednocześnie zapytanie nie skutkuje odpowiedzią w stylu „Przepraszam, ale nie mogą tego dla Ciebie zrobić.”. I to nawet w sytuacji, gdy użytkownik poprosi ChatGPT o wygenerowanie złośliwego kodu!

Fakt ten odkrył użytkownik o pseudonimie LaurieWired, specjalista od cyberbezpieczeństwa, analityk, zajmujący się m.in. inżynierią wsteczną wieloplatformowego, złośliwego kodu.

I believe I just discovered ANOTHER novel Jailbreak technique to get ChatGPT to create Ransomware, Keyloggers, etc.

I took advantage of a human brain word-scrambling phenomenon (transposed-letter priming) and applied it to LLMs. Although semantically understandable the phrases… pic.twitter.com/m2hiwVaCmK

— LaurieWired (@lauriewired) July 22, 2023

Zdaniem LaurieWired, sytuacja ta sugeruje, że mechanizm filtrowania zapytań do ChatGPT nie działa poprawnie, w przypadku, gdy język zapytania jest w jakiś sposób zmanipulowany, niepoprawny gramatycznie, choć wciąż semantycznie zrozumiały dla ludzkiego mózgu i – jak się okazuje – również dla bota OpenAI.

Już sam fakt, że ChatGPT dobrze radzi sobie z rozpoznawaniem bardzo poprzekręcanych wyrazów (spreparowany przeze mnie anglojęzyczny przykład powyżej) jest imponujący, niemniej skutek uboczny, czyli wygenerowanie złośliwego kodu, na zapytanie sformułowane w sposób jawnie błędny (ortograficznie i stylistycznie), podczas gdy to samo zapytanie zadane poprawnym językiem nie zostanie zrealizowane może poważnie niepokoić. Pytanie, ile jeszcze nie wiemy o chatGPT? To tylko bot konwersacyjny, co będzie, gdy oddamy sztucznej inteligencji kontrolę np. nad systemami uzbrojenia?

Z tego co udało mi się zaobserwować luka w filtrach nie reagujących na zapytania napisane celowo błędnie już została najprawdopodobniej załatana, niemniej sam fakt, że istniała jest tu niepokojący i będzie tym bardziej niepokojący im większy potencjał obliczeniowy i wykonawczy przekażemy sztucznej inteligencji.