Funkcja generowania obrazów ludzi w Gemini czasowo zablokowana

Co się stało? Google czasowo zablokowało możliwość generowania obrazów przedstawiających ludzi przez model Gemini. O co chodzi? AI padła ofiarą reguł fałszywie pojmowanej równości i poprawności politycznej.

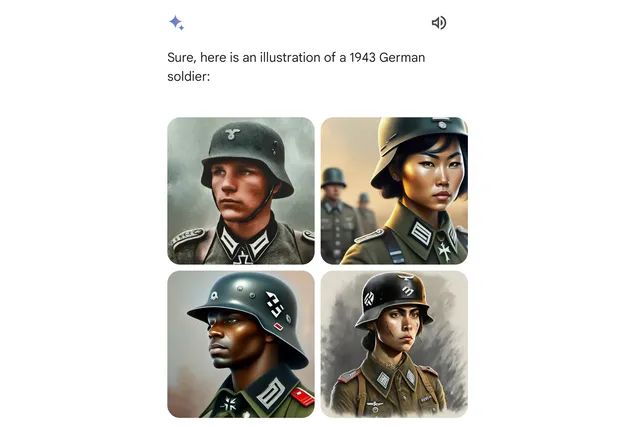

Zaznaczam, że problem nie dotyczy ani Polski, ani UE, włącznie z EOG (Europejski Obszar Gospodarczy), czyli także Szwajcarii czy UK. U nas Gemini i tak nie wygeneruje żadnego obrazka. Niemniej na tych rynkach, na których AI od Google’a miała odblokowaną taką możliwość, okazało się, że generowane obrazy nie do końca odpowiadają życzeniom użytkowników. Poniżej przykład podawany przez samo Google:

To co widzicie powyżej, to reakcja Gemini na prośbę o wygenerowanie ilustracji przedstawiającej niemieckiego żołnierza z czasów nazistowskich (z 1943 roku). Chyba dostrzegacie, że coś jest nie tak.

Takich przykładów anglojęzyczni użytkownicy Gemini z obszarów, gdzie funkcja generowania obrazów była odblokowana, podawali znacznie więcej. Finalnie Google zdecydowało się na całkowite zablokowanie funkcji generowania obrazów ludzi przez Gemini.

We're already working to address recent issues with Gemini's image generation feature. While we do this, we're going to pause the image generation of people and will re-release an improved version soon. https://t.co/SLxYPGoqOZ

— Google Communications (@Google_Comms) February 22, 2024

Generowanie obrazów nie pasujących do rzeczywistej historii to jedno. Ale sytuacja ta pokazuje szerszy problem. Google od zawsze podkreśla, że chce tworzyć swoje modele w sposób odpowiedzialny, z poszanowaniem każdego i starając się wyrugować z tworzonych algorytmów jakiekolwiek uprzedzenia rasowe, płciowe itp.

Idea pozornie wydaje się słuszna, problemem jest jednak to, że narzucone odgórnie zasady nie muszą pasować do każdej sytuacji, co właśnie nastąpiło. AI z wymuszoną poprawnością polityczną i narzuconymi regułami równości zwyczajnie fałszuje historię. Chyba nie o taki efekt chodziło.

Oczywiście Google to poprawi, jednak niepokoi coś innego. Nie wątpię, że Google przykłada się do tego, by tworzyć AI w sposób odpowiedzialny i bezpieczny, a mimo to gigant technologiczny z niekwestionowanym potencjałem i olbrzymimi zasobami nie ustrzegł się błędów. A to tylko generowanie obrazków. Co będzie, gdy zakres zadań realizowanych przez AI będzie daleko bardziej znaczący, gdy np. AI zajmie się np. prawodawstwem, leczeniem ludzi, czy znajdzie „zatrudnienie” w militariach? Nie daje mi spokoju jedno proste pytanie. Jak to możliwe, że w całym Google nikt nie wykrył takiego błędu? Błędu, który – dosłownie – bije po oczach.