Microsoft z nowymi modelami AI – Phi-3: mały, ale potężny

Najbardziej popularne na świecie duże, generatywne modele językowe, na których bazują takie rozwiązania jak ChatGPT, Gemini, Copilot, itp., mają jedną cechą wspólną: są duże. Wymagają olbrzymich zasobów, mocy obliczeniowych i energii. Microsoft proponuje odmienne podejście wraz z debiutem obiecującego, małego modelu Phi-3.

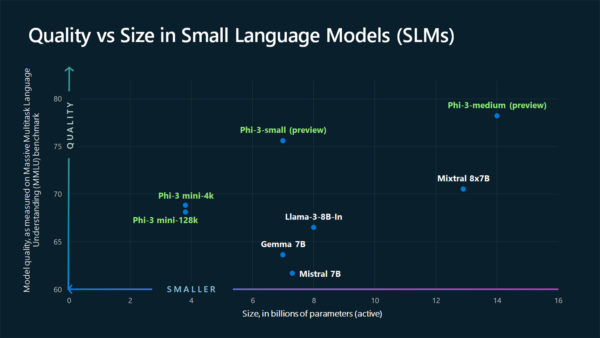

W rzeczy samej, zgodnie z tym, co możemy przeczytać na blogu Azure, Phi-3 to nawet nie jeden model, lecz cała rodzina małych modeli językowych AI (SLM). Jednak to, co je wyróżnia, to fakt, że w przeprowadzonych już testach Phi-3 okazuje się znacznie bardziej wydajny i efektywny niż inne modele tego samego lub większego rozmiaru. Naturalnie rozwiązanie bazujące na Phi-3 nie dorówna co prawda możliwościom modeli LLM (jak np. GPT-4), ale w różnych testach językowych, wnioskowania, autonomicznego kodowania czy w testach matematycznych Phi-3 okazuje się być lepszy od takich rozwiązań jak np. Llama-3 firmy Meta (dawn. Facebook). Microsoft na dowód tego, w oficjalnej informacji opublikował też następujący wykres:

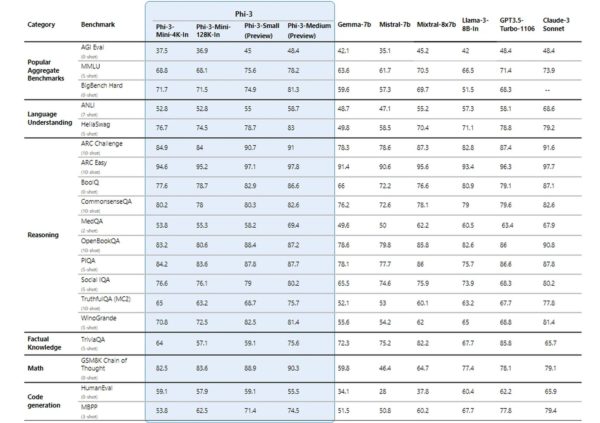

Przyjrzyjmy się powyższemu wykresowi. Jak widać przedstawia on wyniki testów, pozycjonowane jako jakość danego modelu (oś rzędnych; pionowa) względem jego rozmiaru (dokładniej: liczby parametrów w miliardach; oś odciętych, czyli pozioma). Nietrudno zaobserwować, że już najmniejsze modele z rodziny Phi-3 o ok. 4 miliardach parametrów, oferują wyższą jakość niż liczący ok. 8 mld parametrów model Llama-3. Przyjrzyjcie się jeszcze następującej tabeli z wynikami różnych testów porównawczych modeli (źródłem jest również Microsoft):

Tutaj z kolei wyraźnie widać, że w niektórych zadaniach (np. związanych z matematyką) już najmniejszy model Phi-3 znacząco przewyższa nawet tak znane modele jak GPT 3.5-Turbo. Rodzina Phi-3 w wielu zadaniach wyprzedza również otwartoźródłowy model językowy opracowany przez Google’a (Gemma) czy modele Mistral. Wyniki są obiecujące, tym bardziej, że mowa o niedużym modelu.

Sztuczna inteligencja jako pilot w walce powietrznej z ludźmi. Kto wygrał?

Dlaczego to ma znaczenie? Bo pozwala tworzyć bardziej efektywne, a jednocześnie małe, oszczędnie gospodarujące zasobami i energią wyspecjalizowane modele językowe sztucznej inteligencji. Owszem, może te rozwiązania nie będą oferować tak szerokiego zakresu tematów jak Copilot, Gemini Advanced, czy ChatGPT oparty na najnowszym GPT-4 Turbo, ale np. w roli pomocnika księgowej, czy wyspecjalizowanego agenta AI „pracującego” w roli pomocy technicznej firmy zajmującej się konkretną kategorią usług czy produktów, rozwiązania oparte na Phi-3 mogą okazać się bardzo dobre. Co istotne, mały model wykazuje też mniejszą skłonność do konfabulacji, halucynacji i zmyślania, co jest niestety dość częste w przypadku dużych modeli LLM AI.

Jeżeli jesteście zainteresowani poszerzeniem wiedzy, oprócz wspomnianego wcześniej wpisu na blogu Azure, zachęcam też do zapoznania się z inną informacją na temat Phi-3, również opublikowaną przez Microsoft.