Apple uczy AI lepszego projektowania UI

Apple uczy AI lepszego projektowania UI dzięki bezpośredniej współpracy z designerami.

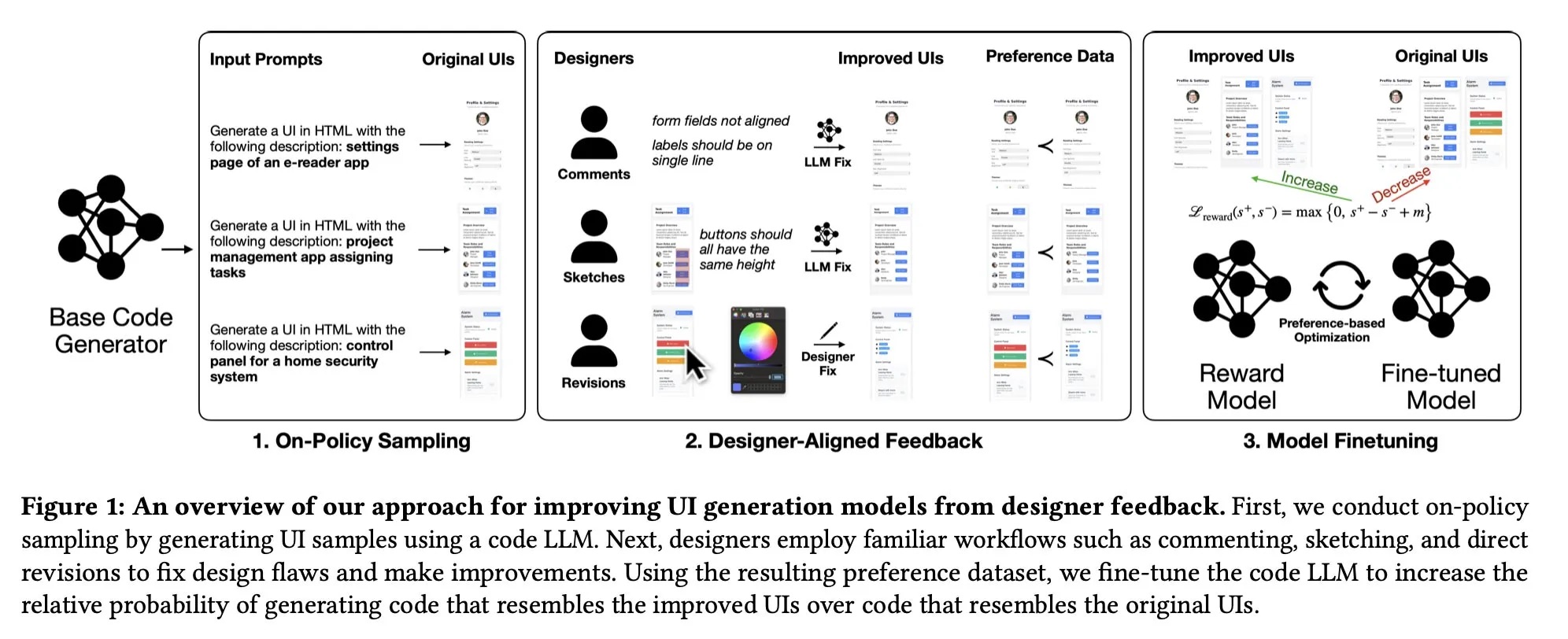

Apple kontynuuje badania nad wykorzystaniem generatywnej AI do tworzenia interfejsów użytkownika. Nowe badanie zespołu odpowiedzialnego za UICoder pokazuje innowacyjne podejście do trenowania modeli AI, które generują funkcjonalny i estetyczny UI.

Tradycyjne metody RLHF (Reinforcement Learning from Human Feedback) nie są wystarczające do tworzenia dobrze zaprojektowanych interfejsów. Apple wprowadziło feedback designerów w formie komentarzy, szkiców i bezpośrednich edycji UI, który następnie służył do trenowania modelu nagrody.

W badaniu wzięło udział 21 profesjonalnych designerów z doświadczeniem od 2 do 30 lat w różnych dziedzinach projektowania. Zebrano 1 460 adnotacji, które pozwoliły stworzyć pary UI „przed i po poprawkach” i użyć ich do fine-tuningu modeli. Modele używane: Qwen2.5-Coder i mniejsze warianty Qwen, z najlepszymi wynikami dla Qwen3-Coder fine-tuned z wykorzystaniem szkiców.

Wyniki?

- Modele trenowane na danych od designerów tworzyły wyraźnie lepsze interfejsy niż standardowe modele czy te trenowane na prostych rankingach.

- Nawet niewielka liczba wysokiej jakości adnotacji (181 szkiców) znacząco poprawiała wydajność modeli.

- Bezpośrednie poprawki i szkice były bardziej zgodne z oczekiwaniami zespołu badawczego niż zwykłe wybory rankingowe (76,1% vs. 49,2%).

Tego typu podejście pozwala AI generować UI bardziej zgodne z rzeczywistymi standardami projektowania. Nawet mniejsze modele mogą przewyższać większe LLM w zakresie projektowania interfejsów, jeśli otrzymają wysokiej jakości feedback ekspercki.

Pełną treść publikacji naukowej Apple znajdziecie tutaj.