AMD rzuca wyzwanie w świecie AI. Nowe akceleratory, otwarta platforma i wsparcie gigantów branży

Podczas wydarzenia „Advancing AI 2025” firma AMD przedstawiła swoją wizję kompleksowego, otwartego ekosystemu sztucznej inteligencji.

Zaprezentowano nowe, potężne akceleratory z serii AMD Instinct MI350, zaktualizowaną platformę oprogramowania ROCm 7 oraz plany rozwoju, które mają zapewnić wiodącą wydajność w skalowalnych rozwiązaniach AI do 2027 roku i później. Firma podkreśliła również silne wsparcie ze strony kluczowych graczy, takich jak Meta, OpenAI, Microsoft i Oracle.

Nowa generacja sprzętu dla ery AI

Najważniejszą informacją zdaniem AMD jest nowa seria akceleratorów AMD Instinct MI350, która ma wyznaczać nowe standardy wydajności i efektywności w dziedzinie generatywnej AI oraz obliczeń o wysokiej wydajności (HPC). Kluczowe cechy nowej serii to:

- 4-krotny wzrost mocy obliczeniowej AI w porównaniu z poprzednią generacją.

- 35-krotny skok wydajności w procesach wnioskowania (inferencji).

- W przypadku modelu MI355X, nawet o 40% więcej generowanych tokenów w przeliczeniu na dolara w porównaniu z konkurencyjnymi rozwiązaniami.

- AMD zapowiedziało również swoją platformę AI nowej generacji o nazwie kodowej „Helios”. Będzie ona oparta na przyszłych akceleratorach Instinct MI400, które mają zapewnić nawet 10-krotnie wyższą wydajność wnioskowania w modelach typu Mixture of Experts, oraz na procesorach EPYC opartych na architekturze „Zen 6”.

Otwarty ekosystem i oprogramowanie

Kluczowym elementem strategii AMD jest budowa otwartego ekosystemu. Firma zaprezentowała najnowszą wersję swojej otwartej platformy programistycznej ROCm 7, która została zaprojektowana z myślą o rosnących wymaganiach generatywnej AI i ma na celu znaczne ułatwienie pracy deweloperom.

Dodatkowo, AMD ogłosiło szeroką dostępność chmury AMD Developer Cloud, która ma obniżyć barierę wejścia i zapewnić programistom dostęp do w pełni zarządzanego środowiska do szybkiego tworzenia projektów AI.

Wiarygodność nowej platformy potwierdza szerokie grono partnerów. Obecnie siedem z dziesięciu największych firm zajmujących się sztuczną inteligencją wykorzystuje akceleratory AMD Instinct w swoich produkcyjnych systemach. O jakich firmach mowa? Oto one:

- Meta potwierdziła, że akceleratory MI300X są szeroko stosowane do wnioskowania w modelach Llama 3 i Llama 4

- OpenAI poinformowało o bliskiej współpracy z AMD i wykorzystaniu MI300X na platformie Azure do badań i obsługi modeli GPT

- Oracle Cloud Infrastructure (OCI) jest jednym z pierwszych dostawców, który wdraża nową, otwartą infrastrukturę AMD i planuje oferować klastry AI w skali „zetta” z wykorzystaniem nawet 131 072 akceleratorów MI355X.

- Microsoft ogłosił, że akceleratory MI300X obsługują już zarówno autorskie, jak i otwarte modele AI na platformie Azure.

Nacisk na efektywność energetyczną

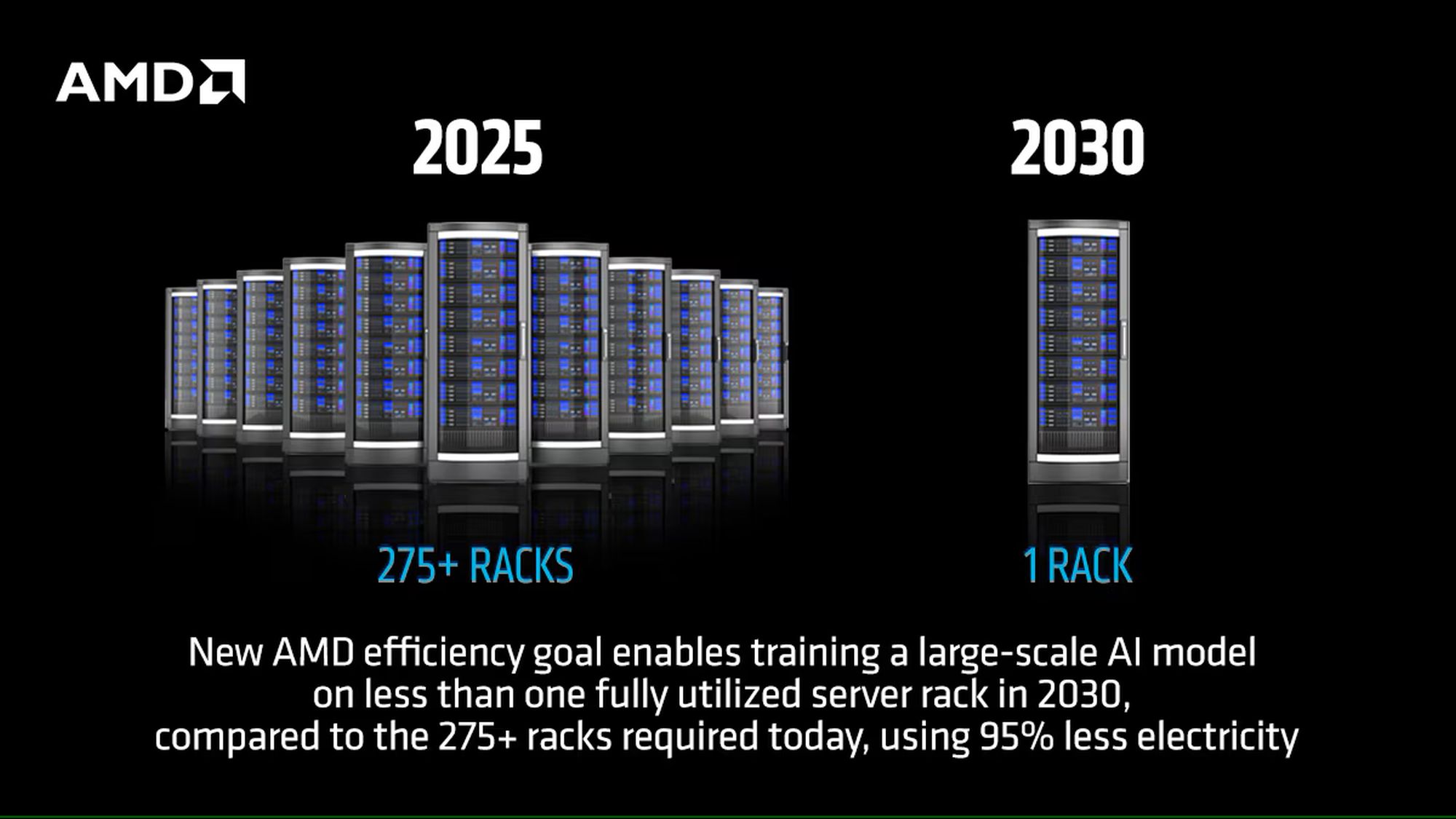

AMD podkreśliło również swoje osiągnięcia w dziedzinie efektywności energetycznej. Seria MI350 przewyższyła pięcioletni cel firmy, osiągając 38-krotną poprawę efektywności energetycznej w węzłach do trenowania AI i HPC. Firma wyznaczyła też nowy cel na 2030 rok: 20-krotne zwiększenie efektywności energetycznej w skali całego racka serwerowego. Ma to umożliwić trenowanie modelu, który dziś wymaga ponad 275 szaf serwerowych, w mniej niż jednej szafie, zużywając przy tym 95% mniej energii elektrycznej.

AMD i HUMAIN łączą siły w inwestycji 10 miliardów USD w infrastrukturę AI