Apple znalazło sposób na „akwarelę” w zdjęciach nocnych. Oto DarkDiff – AI, które widzi w ciemnościach

Każdy z nas to zna. Robisz zdjęcie w słabym świetle, na ekranie telefonu wygląda świetnie, ale po przybliżeniu detale znikają w masie cyfrowego szumu lub – co gorsza – zamieniają się w gładką, olejną plamę.

Badacze Apple (wspólnie z Purdue University) opublikowali właśnie pracę, która może zakończyć erę „rozmydlonych” zdjęć nocnych. Rozwiązaniem jest… zaprzęgnięcie modelu generatywnego (takiego jak Stable Diffusion) bezpośrednio do procesora obrazu.

W opublikowanej pracy naukowej zatytułowanej „DarkDiff: Advancing Low-Light Raw Enhancement by Retasking Diffusion Models for Camera ISP”, inżynierowie Apple stawiają sprawę jasno: tradycyjne algorytmy odszumiania oraz dotychczasowe modele oparte na regresji mają wadę – dążą do uśredniania pikseli, co skutkuje utratą tekstur i detali, czyli właśnie wspomnianym efektem „rozwodnienia”.

Odpowiedzią ma być DarkDiff.

Jak to działa? AI wchodzi w surowy plik RAW

Zamiast naprawiać zdjęcie po jego zrobieniu (jak robi to większość dzisiejszych edytorów AI), DarkDiff ingeruje w proces znacznie wcześniej.

Najpierw system bierze dane bezpośrednio z matrycy (Bayer Raw). Kolejny etap to konwersja. Algorytm zamienia je na liniową przestrzeń RGB (Linear RGB), co ułatwia pracę modelowi. Kluczowy etap to generowanie detali.

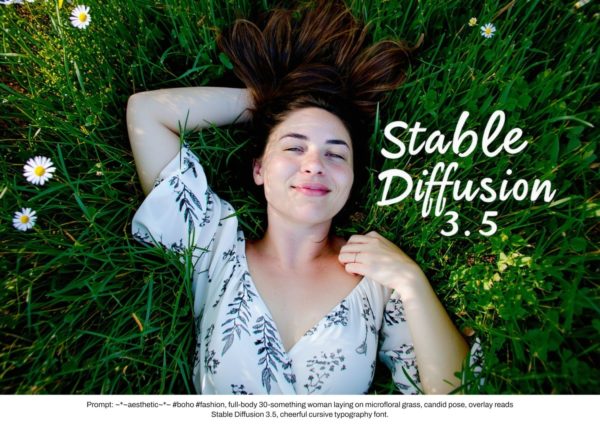

Badacze wykorzystali wstępnie wytrenowany model dyfuzyjny (w badaniu użyto Stable Diffusion V2-1 ), ale „przestroili” go tak, by nie tworzył obrazów z niczego, lecz odzyskiwał je z szumu.

A co z halucynacjami?

Głównym problemem modeli generatywnych jest to, że lubią zmyślać (halucynować). Jeśli AI zobaczy plamę w ciemności, może uznać, że to pies, choć w rzeczywistości to śmietnik. Aby temu zapobiec, Apple opracowało mechanizm, który nazwano Region-based Cross-Attention. Dzięki niemu model AI skupia się na lokalnych, małych fragmentach obrazu i jest ściśle „pilnowany” przez surowe dane z matrycy. Efekt? AI odzyskuje teksturę liści czy napisów na książce, ale podobno nie dorysowuje tam obiektów, których nie było.

W badaniu porównano DarkDiff z obecnymi liderami rynku. Wyniki (mierzone wskaźnikiem percepcji LPIPS) są jednoznaczne – rozwiązanie Apple deklasuje konkurencję pod względem naturalności obrazu.

Kiedy w iPhonie? Jest jeden haczyk

Czy zobaczymy to w iPhonie 17? Niekoniecznie. Badacze wprost przyznają, że proces dyfuzji jest bardzo wymagający obliczeniowo i zajmuje dużo czasu. W obecnej formie DarkDiff mógłby wymagać przetwarzania w chmurze, zamiast na urządzeniu, co kłóci się z polityką prywatności Apple i dbałością o baterię.

Jednak sam fakt, że Apple inwestuje w generatywne modele wewnątrz potoku ISP (Image Signal Processor), pokazuje kierunek: przyszłe iPhone’y nie będą już tylko „robić” zdjęć. Będą je na nowo generować na podstawie tego, co w specyficznych (trudnych) warunkach (ledwo) widzi matryca.