Apple wprowadza nowe funkcje dla dostępności

Wczoraj Apple udostępniło komunikat prasowy, który po raz kolejny jednoznacznie wskazuje na podejście firmy do wdrażania nowych technologii. To jest proste: musi realnie pomagać człowiekowi.

Apple z okazji Światowego Dnia Świadomości Dostępności zapowiedziało wprowadzenie nowych funkcji dostępności na iOS, iPadOS i macOS w późniejszym terminie (w tym roku).

Firma skupiła się na szerokim zakresie funkcji dostępności, obejmujących zmysł wzroku, słuchu, ruchu i mowy. Całość została zaprojektowana przy wsparciu społeczności osób niepełnosprawnych. Apple nie podało dokładnej daty premiery tych funkcji w swoich systemach operacyjnych, ale jeśli poprzednie lata mogą być jakimś wyznacznikiem, większość z nich powinna zostać wdrożona jesienią w ramach corocznej aktualizacji systemów operacyjnych firmy.

Assistive Access

Assistive Access to nowy, dostosowywalny tryb dla iPhone’a i iPada, stworzony dla użytkowników z niepełnosprawnościami poznawczymi, aby ułatwić korzystanie z ulubionych aplikacji. Apple współpracował zarówno z użytkownikami, jak i ich zaufanymi wspierającymi, aby skoncentrować się na najczęściej używanych czynnościach, takich jak komunikacja z przyjaciółmi i rodziną, robienie i przeglądanie zdjęć oraz słuchanie muzyki. Efektem jest uproszczenie doświadczeń związanych z powiązanymi aplikacjami. Na przykład aplikacje Telefon i FaceTime zostały połączone w jedną aplikację Calls, która obsługuje zarówno rozmowy audio, jak i wideo.

Interfejs użytkownika w trybie Assistive Access jest bardzo elastyczny i pozwala użytkownikom oraz ich zaufanym wspierającym dostosować go do swoich indywidualnych potrzeb. Na przykład ekran główny iPhone’a może być uproszczony tak, aby wyświetlał tylko kilka aplikacji z dużymi przyciskami o wysokim kontraście i dużymi etykietami tekstowymi. Alternatywnie, Assistive Access można skonfigurować z interfejsem opartym na wierszach tekstu dla osób preferujących tekst.

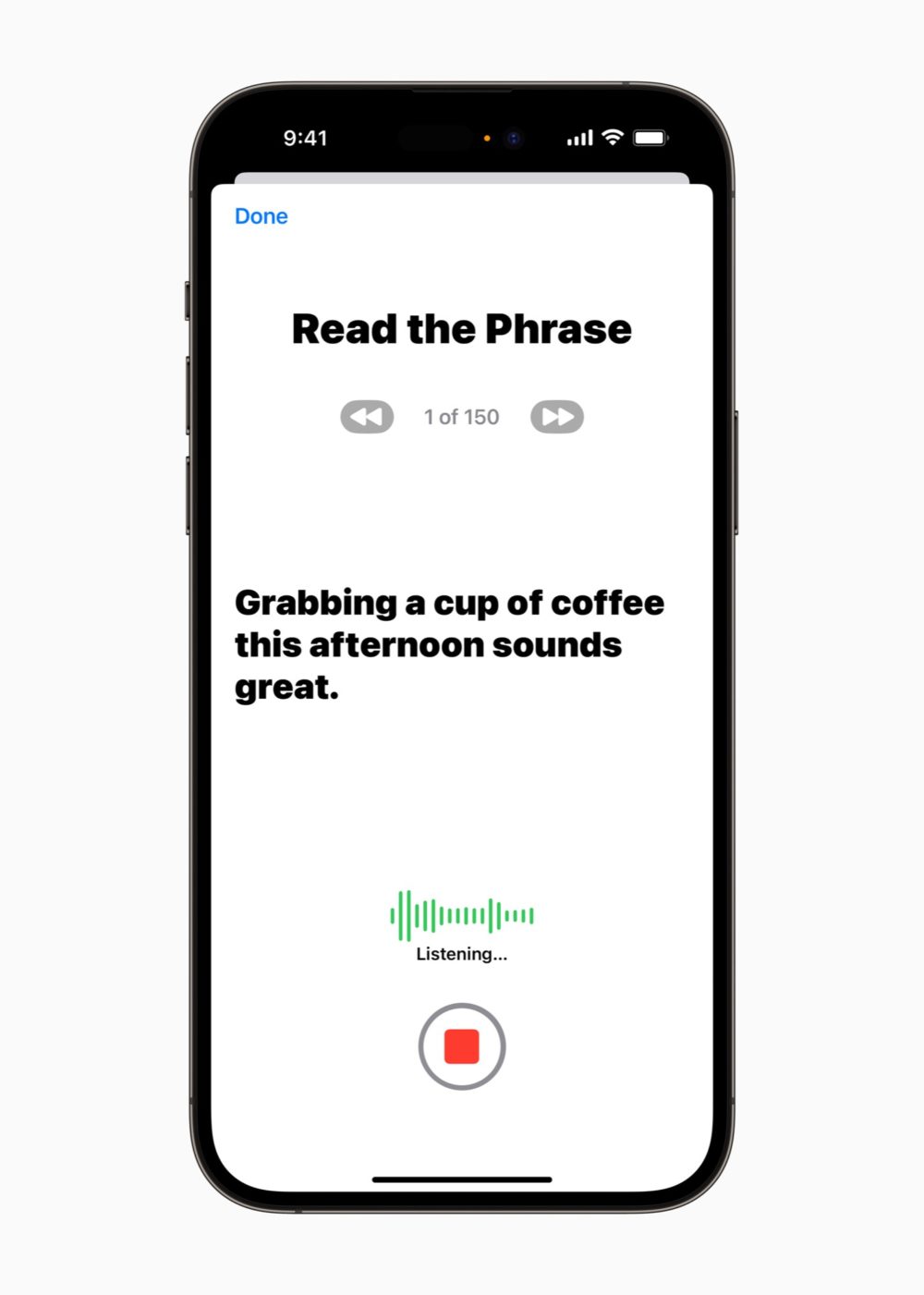

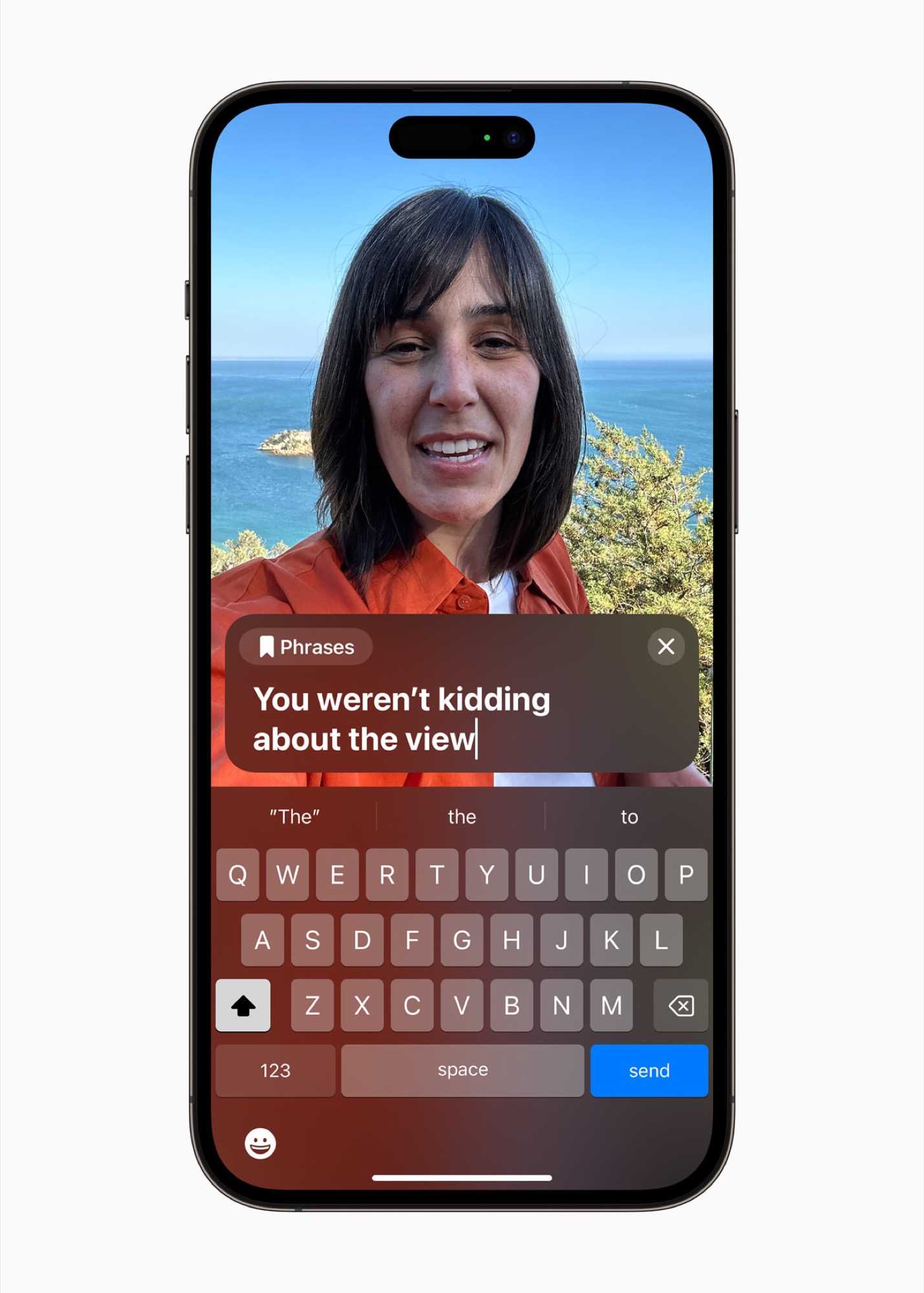

Live Speech i Personal Voice

Live Speech to natomiast nowa funkcja, która działa na iPhone’ach, iPadach i komputerach Mac, umożliwiając użytkownikom, którzy nie potrafią mówić, wpisywanie odpowiedzi, a te są przetwarzane na – ich! – na głos podczas rozmów telefonicznych i wideorozmów w aplikacji Phone i FaceTime, a także podczas rozmów 1:1 z drugą osobą.

Apple ogłosiło również Personal Voice, który wykorzystuje moc procesorów Apple Silicon i silnik neuronowy do pomocy osobom, które są narażone na utratę zdolności mówienia. Funkcja umożliwia nagranie 15 minut losowych promptów tekstowych na iPhone’ie, iPadzie lub komputerze Mac z procesorem Apple Silicon, które Personal Voice wykorzystuje do stworzenia syntetycznego głosu użytkownika. Proces odbywa się na urządzeniu przy użyciu uczenia maszynowego i może być zsynchronizowany z innymi urządzeniami za pomocą end-to-endowego szyfrowania iCloud, jeśli użytkownicy wyrażą na to zgodę. Na początku Personal Voice będzie dostępne tylko w języku angielskim.

Point and Speak w aplikacji Magnifier

Magnifier to doskonałe narzędzie dostępności, które zostanie jeszcze bardziej ulepszone dzięki funkcji Point and Speak. Funkcja ta jest rozszerzeniem trybu Detection Mode, który został wprowadzony w zeszłym roku (wraz z iOS 16) i pomaga osobom niewidomym i niedowidzącym znajdować i poruszać się przy drzwiach. Podobnie jak ta funkcja, Point and Speak wykorzystuje możliwości aparatu, technologii LiDAR i rozpoznawania tekstu do pomocy użytkownikom w interakcji z przedmiotami w ich otoczeniu, takimi jak urządzenia domowe.

Użytkownik może przyłożyć iPhone’a lub iPada do mikrofalówki, a następnie przesuwać palcem po każdym przycisku, a aplikacja Magnifier będzie czytać tekst z etykiety przycisku. Jest to znakomita synergia kilku technologii sprzętowych i programowych, które sprowadzają się do jednej prostej funkcji, obiecującej ułatwienie codziennego życia wielu użytkownikom.

Funkcja Point and Speak będzie wymagać iPhone’a lub iPada z czujnikiem LiDAR i będzie obsługiwać języki: angielski, francuski, włoski, niemiecki, hiszpański, portugalski, chiński, kantoński, koreański, japoński i ukraiński.

Inne funkcje

Apple ogłosiło również zestaw innych nowych funkcji dostępnościowych, które zostaną wprowadzone w tym roku:

- Aparaty słuchowe Made for iPhone będą działać z komputerami Mac M1 i M2.

- Voice Control zyska sugestie fonetyczne dla słów o podobnym brzmieniu podczas edytowania tekstu w języku angielskim, hiszpańskim, francuskim i niemieckim.

- Na iPhone’a, iPadzie i komputerze Mac zostanie dodany przewodnik Voice Control, który udzieli wskazówek dotyczących korzystania z tej funkcji.

- Switch Control pozwoli na wykorzystanie przełącznika jako kontrolera gier.

- Prostowanie rozmiaru tekstu będzie łatwiejsze w aplikacjach na Macu, takich jak Finder, Messages, Mail, Calendar i Notes.

- Animacje w aplikacjach Messages i Safari będą automatycznie zatrzymywać się dla użytkowników wrażliwych na szybkie animacje.

- Głosy Siri będą brzmieć naturalnie dla użytkowników VoiceOver przy odtwarzaniu w prędkościach od 0,8x do 2x.

- W ramach obchodów Światowego Dnia Świadomości Dostępności, Apple rozszerza program SignTime na więcej swoich sklepów. Program ten oferuje tłumaczenie języka migowego na żądanie dla klientów sklepów Apple Store i Apple Support i zostanie rozszerzony 18 maja na Włochy, Niemcy, Hiszpanię i Koreę Południową.