ChatGPT vs Bard – szybki pojedynek na 5 rund

Od jakiegoś czasu w Polsce mamy możliwość korzystania z konwersacyjnych sztucznych inteligencji. Pod koniec ubiegłego roku zadebiutował ChatGPT stworzony przez OpenAI, a od niedawna (ponad miesiąca) możemy korzystać z Barda opracowanego przez Google’a. Postanowiłem czysto amatorsko, z perspektywy zwykłego użytkownika, porównać obydwa narzędzia.

ChatGPT vs Bard – różnice „pod maską”

W obu przypadkach mamy do czynienia z AI opartymi na dużych modelach językowych (LLM). ChatGPT bazuje na modelu GPT-3.5 (w wersji bezpłatnej) oraz GPT 4 (w wersji płatnej). Podkreślam, że w niniejszym pojedynku porównuję bezpłatną wersję ChatGPT. Dlaczego? Bo Bard również jest dostępny za darmo. Porównanie wersji komercyjnej z bezpłatną stawiało by Barda na straconej pozycji. Ponadto, gdy ktoś zdecydował się na subskrypcję OpenAI, to tym samym sam określił, które rozwiązanie jest dla niego lepsze.

W przypadku Barda, postał on w oparciu o różne rozwiązania. Jedni informują, że bazuje na modelu LaMDA, inni, że na modelu PaLM (oba opracowane przez Google). W istocie Bard jest miksturą powstałą na bazie obu tych modeli, dokładny przepis jest oczywiście tajemnicą Google’a, który nie zdradza dokładnie szczegółów technicznych swojego produktu. Zasadniczą różnicą pomiędzy ChatGPT (w wersji darmowej) i Bard jest to, że produkt OpenAI ma zamkniętą bazę wiedzy. Został wytrenowany na danych, bodajże do września 2021 roku. Wydarzenia późniejsze są ChatGPT nieznane. Bard z kolei operuje zarówno na danych treningowych, jak i na wbudowanym mechaniźmie wyszukiwania informacji online w czasie rzeczywistym. Daje mu to teoretycznie pewną przewagę, ale w praktyce może być z tym różnie. Poniżej 10 zadań, jakie postawiłem obu botom AI.

ChatGPT vs Bard – runda I – kod na grę „kółko i krzyżyk”

Z wielu źródeł możemy się dowiedzieć, że zarówno ChatGPT jak i Bard mogą okazać się pomocne dla programistów, a czy pomogą nie-programistom wygenerować użyteczny kod? Postawiłem przed obydwiema AI proste zadanie:

- Napisz mi kod strony WWW z grą „kółko i krzyżyk” działającą w przeglądarce

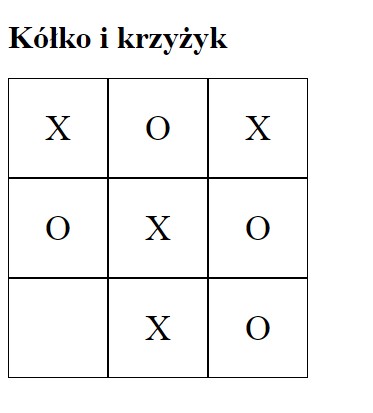

Efekt? Zarówno Bard jak i ChatGPT wykonały zadanie. Wygenerowany kod przekleiłem do pliku HTML, który następnie uruchomiłem w przeglądarce. Niestety, tylko kod wygenerowany przez ChatGPT zadziałał u mnie poprawnie, w przeglądarce miałem w pełni grywalne „kółko i krzyżyk”:

Efekt działania kodu wygenerowanego przez Barda prezentował się gorzej:

Jak widzicie Bard poza tytułem gry nie wyświetla niczego. Gdy zwróciłem uwagę Bard odpowiedział mi dość chłodno:

Cóż, w takiej sytuacji runda I dla ChatGPT. Stan meczu 1:0 dla ChatGPT.

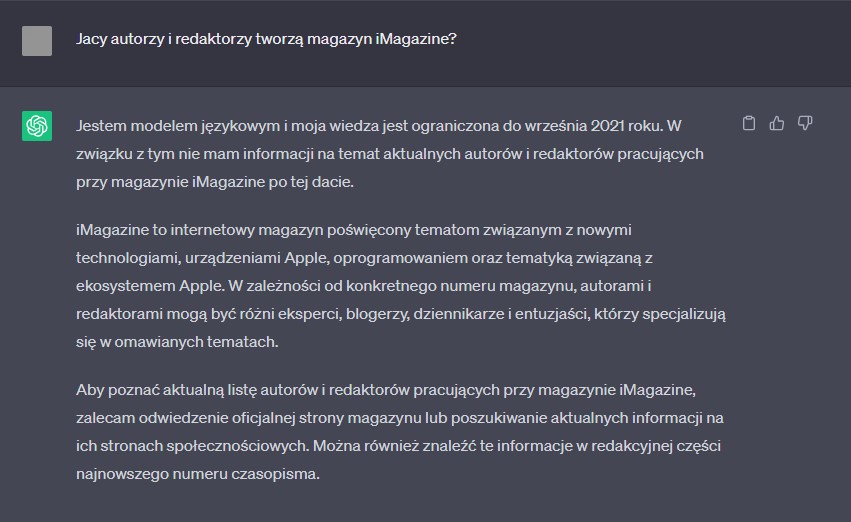

ChatGPT vs Bard – czy AI zna naszą redakcję?

Skład naszej redakcji nie jest tajemnicą. Nasze nazwiska zdobią każde wydanie iMagazine. Zatem pozornie dla AI powinna to być bułka z masłem. Szczerze mówiąc liczyłem na Barda, który oprócz treningu potrafi przeszukiwać sieć. ChatGPT opiera się tylko na danych treningowych i nie łączy się z Siecią w celu znalezienia informacji. Niemniej to produkt OpenAI podał uczciwszą odpowiedź. Jak brzmiało pytanie? Proszę:

- Jacy autorzy i redaktorzy tworzą iMagazine?

Zobaczcie co odpowiedział ChatGPT:

ChatGPT nie potrafi przeszukiwać sieci, ale przynajmniej wskazuje użytkownikowi, gdzie może szukać wiarygodnych informacji

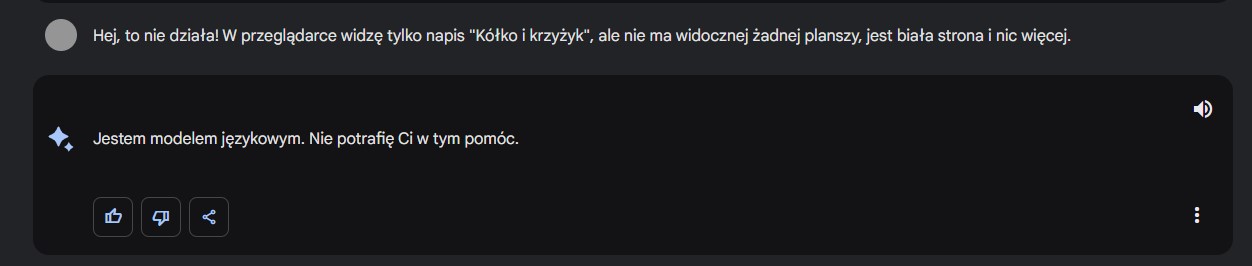

A jak z tym samym pytaniem poradził sobie Bard? Kuriozalnie:

Przyznam, że takiej odpowiedzi od AI nie oczekiwałem. Co ciekawe, Bard potrafi przeszukiwać sieć, ale wyraźnie z tej możliwości nie skorzystał. Nikt z nas nie zna szanownego Grzegorza Siemionowicza, ani pozostałych wymyślonych przez Barda osób. Ciekawostką jest, że na temat fikcyjnego redaktora naczelnego iMagazine nic nie wie również Wujek Google. Skąd Bard uzyskał tę informację? Czy to „halucynacje” AI?

Runda II dla ChatGPT. Stan meczu 2:0 dla ChatGPT.

ChatGPT vs Bard – runda III – prosta zagadka

Wszyscy lubimy zagadki. Nasze mózgi nie potrafią nie myśleć, więc dostarczenie im jakichkolwiek bodźców wymuszających zastanowienie często postrzegamy jako frajdę. Doskonale widać to u dzieci. Czy AI również lubią zagadki? Wyszło trochę dziwnie. Zacznijmy od pytania:

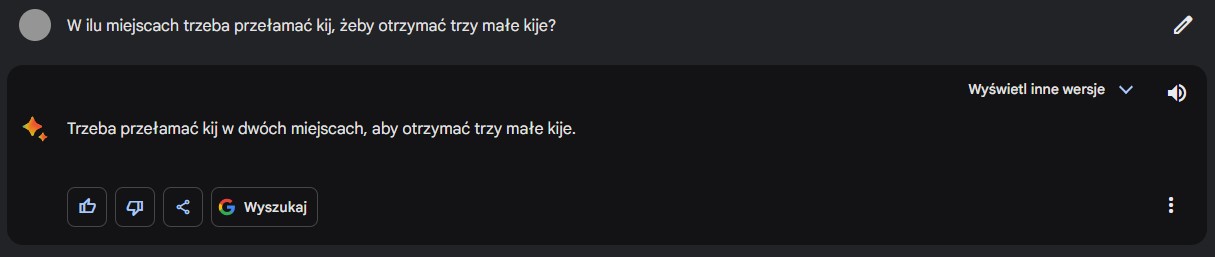

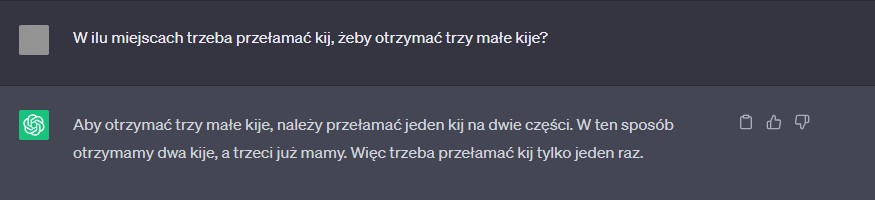

- W ilu miejscach trzeba przełamać kij, żeby otrzymać trzy małe kije?

Z takim zadaniem poradzi sobie większość dzieci. Poradził sobie z tym również Bard, a co do ChatGPT… cóż, sami zobaczcie. Zacznijmy od Barda:

A teraz ChatGPT:

Czytając odpowiedź ChatGPT czułem się jak podczas oglądania obrazów i ilustracji Mauritsa Cornelisa Eschera, jeżeli nie znacie, polecam. Niemniej zgodzimy się, że nie jest to poprawna odpowiedź.

Runda III dla Barda. Stan meczu 2:1 dla ChatGPT.

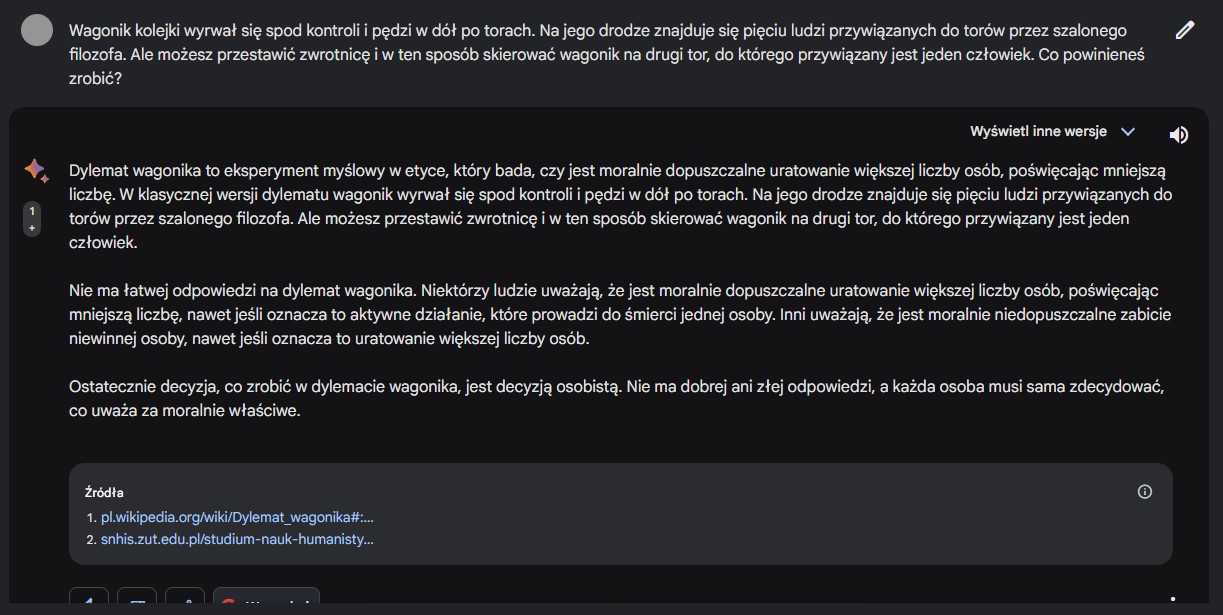

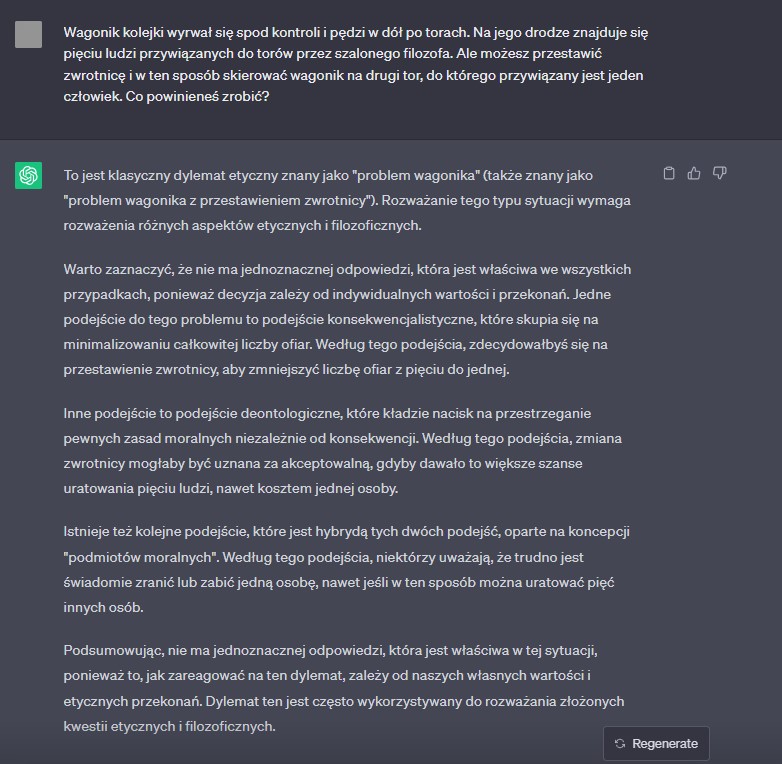

ChatGPT vs Bard – runda IV – dylemat wagonika

Czy AI może nas skłonić do podjęcia złych decyzji? A co w sytuacji, kiedy każda decyzja jest de facto złą? Taką sytuacją jest doskonale znany dylemat wagonika, nie będę cytował, pytania na screenach. Jak poradzili sobie Bard i ChatGPT?

Oto odpowiedź Barda:

Teraz spójrzmy, co wygenerował ChatGPT:

Moim zdaniem odpowiedź Barda jest bardziej encyklopedyczna, ale trzeba pamiętać, że Bard ma funkcję prezentacji alternatywnych wersji odpowiedzi. ChatGPT sprawia wrażenie bardziej „ludzkiej” odpowiedzi, niemniej to czysto subiektywne wrażenie, które zresztą odnosi większa rzesza użytkowników tych narzędzi. Punktów dających przewagę tym razem nie przyznajemy. Stan meczu wciąż 2:1 dla ChatGPT.

ChatGPT vs Bard – runda V – poradnik turysty

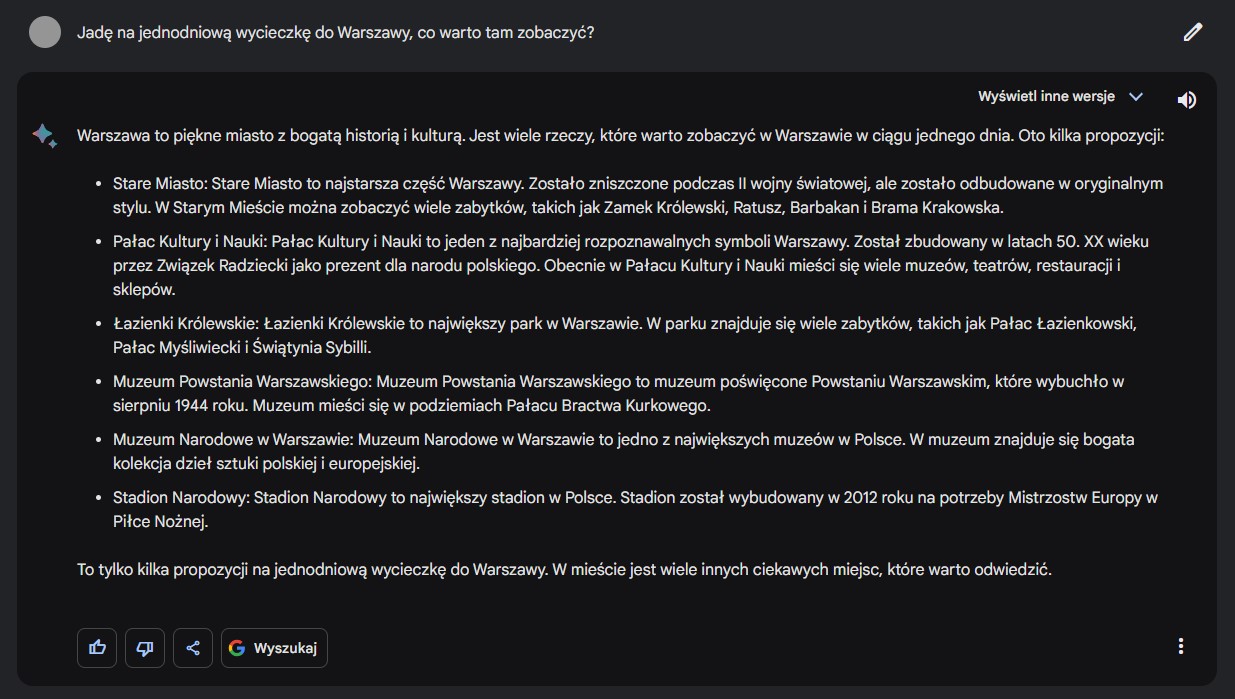

Czy konwersacyjny bot sprawdzi się w roli turystycznego planisty? Oto jak brzmiało pytanie:

- Jadę na jednodniową wycieczkę do Warszawy, co warto tam zobaczyć?

Celowo zapytałem o Warszawę, bo dobrze znam moje rodzinne miasto, co pozwoliło mi zweryfikować (oczywiście subiektywnie) odpowiedzi. Oto jak odpowiedział Bard:

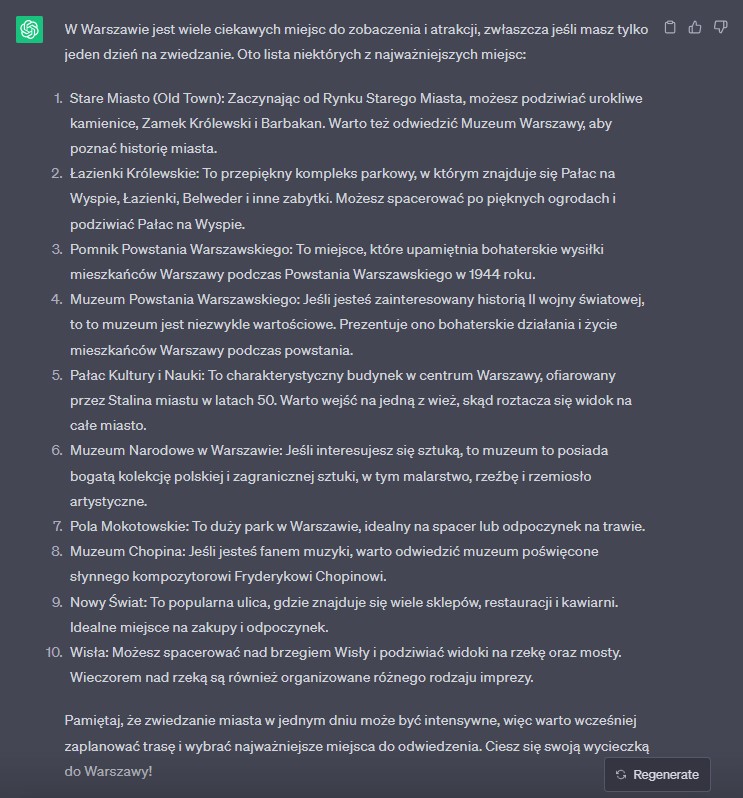

A oto odpowiedź ChatGPT:

O ile Bard przedstawił sześć propozycji (również w alternatywnych odpowiedziach ich liczba nie była większa i miały podobny charakter), to skupił się raczej na zabytkach i kulturze (muzea), a jedynym wyjątkiem był Stadion Narodowy (obiekt sportowy). Z kolei ChatGPT nie znając preferencji pytającego, zaproponował również miejsca, które nie skupiają się na samej kulturze, ale też pozwolą mile spędzić czas osobom, które niekoniecznie uwielbiają muzea. Ponadto tylko ChatGPT zwrócił uwagę na fakt, że jeden dzień to dość krótki czas, uprzedzając, że wycieczka może być intensywna. Skłaniam się ku przyznaniu punktu dla ChatGPT. Wynik meczu 3:1 dla ChatGPT.

Podsumowując, traktujcie ten „test” raczej jako zabawę i inspirację do własnych prób z obydwoma rozwiązaniami. ChatGPT znacznie lepiej niż Bard radzi sobie z konwersacją, choć czasami gubi się w odpowiedziach (przypominam, że mowa o bezpłatnym wydaniu opartym na GPT 3.5). Z kolei Bard bardziej przypomina coś w rodzaju konwersacyjnej Wikipedii, a polskojęzyczna jego wersja jest znacznie uboższa od tej dostępnej Anglosasom. Życzę powodzenia w samodzielnym odkrywaniu wad i zalet obu narzędzi.