MrBeast wykorzystany do promowania oszustw za pomocą techniki Deepfake

Najpopularniejszy na świecie YouTuber, MrBeast (Jimmy Donaldson), i dwójka prezenterów BBC, zostali wykorzystani do promowania oszustw. Cyberprzestępcy za pomocą AI i techniki Deepfake stworzyli fałszywe filmy, w których widzowie byli nakłaniani do oszukańczych zakupów i inwestycji.

Film wykorzystujący wizerunek MrBeast pojawił się w tym tygodniu na TikToku. Wygenerowany przez AI „YouTuber” oferował nowe iPhone’y za 2 dolary. Z kolei materiały z podobiznami gwiazd BBC: Matthew Amroliwala i Sally Bundock zostały wykorzystane do promowania oszustwa. Wideo na Facebooku pokazywało wygenerowanych przez AI dziennikarzy „przedstawiających” Elona Muska rzekomo promującego okazję inwestycyjną.

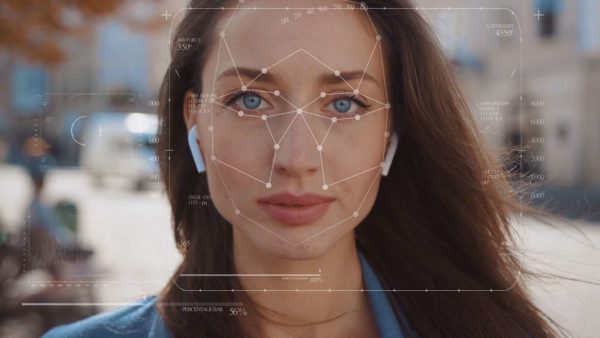

Technika Deepfake nie jest nowością, bo można było o niej usłyszeć już w 2017 roku. Jednak stale ewoluuje. O ile początkowo nawet nieszczególnie biegli w temacie widzowie mogli dostrzec różnice w zmanipulowanym obrazie, to dziś jest to już znacznie trudniejsze. W zasadzie ludzka percepcja jest już bezradna w obliczu tego typu manipulacji.

Materiały typu deepfake wykorzystują sztuczną inteligencję do tworzenia filmów lub zdjęć z wizerunkiem wybranych osób, które do złudzenia przypominają prawdziwe. Filmy stworzone przez AI pozwalają przypisać prawie każdej osobie dowolne słowa, nawet te, których nigdy nie wypowiedziała. Jedynym warunkiem stworzenia takiego materiału jest dostęp do większej liczby filmów wideo z udziałem danej osoby. To na ich podstawie AI generuje nowy materiał.

Dostarczanie materiałów do deepfake’ów to zagrożenie związanie z korzystaniem z social mediów, o którym rzadko myślimy. Nie dotyczy ono tylko twórców internetowych i celebrytów. Wiele z nas, przez lata publikowało materiały wideo, które teraz mogą posłużyć od kradzieży naszego wizerunku i tworzenia naszych wypowiedzi. W ten sposób można oszukać np. naszych najbliższych, a nawet zniszczyć naszą reputację – mówi Beniamin Szczepankiewicz, analityk laboratorium antywirusowego ESET

Ekspert dodaje

– Jeszcze pięć lat temu wykrywanie sfabrykowanych filmów i obrazów było stosunkowo proste, ale z biegiem stało się znacznie trudniejsze. Obecnie coraz trudniej stwierdzić czy dany materiał jest wytworem AI. Dlatego warto poważnie przemyśleć swoją aktywność internetową, a zwłaszcza publikowanie filmów z udziałem dzieci. Obecnie, narzędzia do tworzenie materiałów deepfake są na wyciągnięcie ręki dla każdego cyberprzestępcy. Niebawem może okazać się, że szantaże czy oszustwa poprzez filmy będą równie częste jak tzw. kradzież „na wnuczka”. Bardzo szybko rozwija się technologia związana z klonowaniem głosu. Łatwo więc sobie wyobrazić, że ktoś np. otrzymuje film, w którym osoba z jego rodziny prosi o pomoc lub słyszy głos bliskiej osoby z prośbą przekazania pieniędzy. Dlatego tak ważne jest by wszelkie prośby o pomoc weryfikować kontaktując się z taką osobą innym kanałem komunikacji.

Jeżeli korzystamy z technologii cyfrowych całkowite zniwelowanie tego typu zagrożenia jest bardzo trudne, ale można je ograniczyć stosując się do następujących zasad podczas korzystania z mediów społecznościowych:

- Ustaw profile w mediach społecznościowych jako prywatne – dzięki temu tylko znajomi będą mogli oglądać twoje materiały.

- Dokładnie sprawdzaj, kogo akceptujesz w gronie „wirtualnych” znajomych – mogą to być nieprawdziwe profile, które zyskają dostęp do twoich danych.

- Zastanów się dwa razy, zanim opublikujesz coś w trybie publicznym.

- Nie publikuj filmów z udziałem innych osób, które nie wyraziły na to zgody.

- Nie publikuj filmów z udziałem dzieci, zwłaszcza jeżeli rodzice lub opiekunowie nie wyrazili na to zgody.

- Edukuj – to bardzo ważne, żeby jak najwięcej osób miało świadomość tego, że nie wszystkie materiały wideo są prawdziwe. Rozmawiaj o tym z dziećmi, osobami starszymi i każdym, kto nie ma wystarczającej wiedzy o świecie cyfrowym.