OpenAI Sora – napisz polecenie, otrzymasz film

O tym, że generatywne modele AI mogą być wykorzystywane nie tylko do tworzenia statycznych obrazów, ale i krótkich klipów wideo wiadomo było już wcześniej, choć efekty były różne. OpenAI ogłosiło własny model Sora.

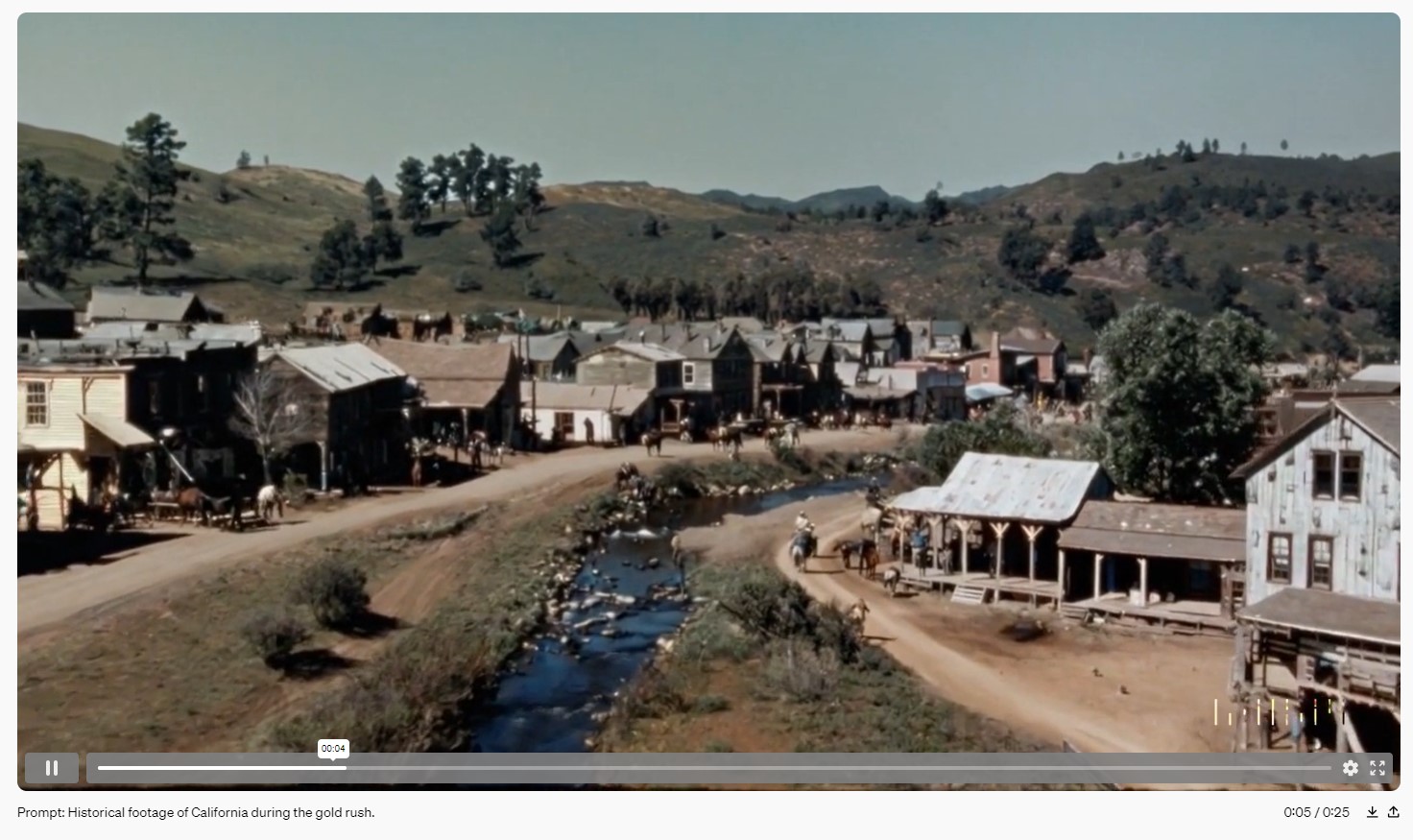

Póki co Sora nie jest jeszcze udostępniona publicznie. Model udostępniono wewnętrznemu zespołowi OpenAI, który ma go ocenić pod względem „szkód lub zagrożeń”. Efekty możecie podziwiać na domowej stronie projektu. Podobno każde wideo wyświetlane na tej stronie zostało wygenerowane właśnie przez model Sora, bez żadnych dodatkowych modyfikacji. Polecenia, które posłużyły do wygenerowania prezentowanych klipów również są ujawnione. Efekty są imponujące, a same klipy to nie kilkusekundowe wstawki, lecz trwające nawet minutę ujęcia wideo.

Rezultaty są znacznie lepsze od czegokolwiek, co dotychczas widziałem, choć wciąż nie są wolne od błędów, jednak teraz trudniej je dostrzec (np. gdy obejrzycie uważnie wygenerowany klip przedstawiający kobietę spacerującą po oświetlonej neonami ulicy Tokio, w pewnym momencie może uchwycicie, że Sora, AI odpowiedzialna za wygenerowanie tego wideo, pomieszała nogi wirtualnej spacerowiczce. Podobne drobne mankamenty czujne oko wyłapie i w innych prezentowanych na stronie klipach (jest ich całkiem sporo). Jednak poza tym, efekt wow gwarantowany.

Jeszcze ciekawsze jest podejście zastosowane przez OpenAI podczas tworzenia Sora AI. Zakłada ono, że modele generowania wideo nie są prostą ekstrapolacją modeli generujących obrazy. To jest kwestia skali, że oto powiększamy model odpowiedzialny za statyczne zdjęcia, by był w stanie robić nie mniej niż 24 zdjęcia na sekundę i oto mamy film. Jest zupełnie inaczej, OpenAI twierdzi, że opracowuje modele generowania wideo jako… symulatory świata.

Zgodnie z deklaracjami OpenAI, model Sora jest obecnie w stanie wygenerować jednominutowy klip wideo o wysokiej wierności. Przedstawiciele OpenAI sami zwracają uwagę, że wiele wcześniejszych prac dotyczących generatywnego modelowania danych wideo skupiało się na użyciu różnych metod, w tym sieci rekurencyjnych, generatywnych sieci przeciwstawnych, transformatorów autoregresyjnych, czy modeli dyfuzyjnych. Prace te często koncentrują się na wąskiej kategorii danych wizualnych, na znacznie krótszych filmach lub klipach o stałym rozmiarze. Sora to ogólny model danych wizualnych — może generować filmy i obrazy o różnym czasie trwania, proporcjach i rozdzielczościach, aż do pełnej minuty wideo w wysokiej rozdzielczości.