Apple publikuje szczegóły dotyczące nowego modelu AI o nazwie MM1

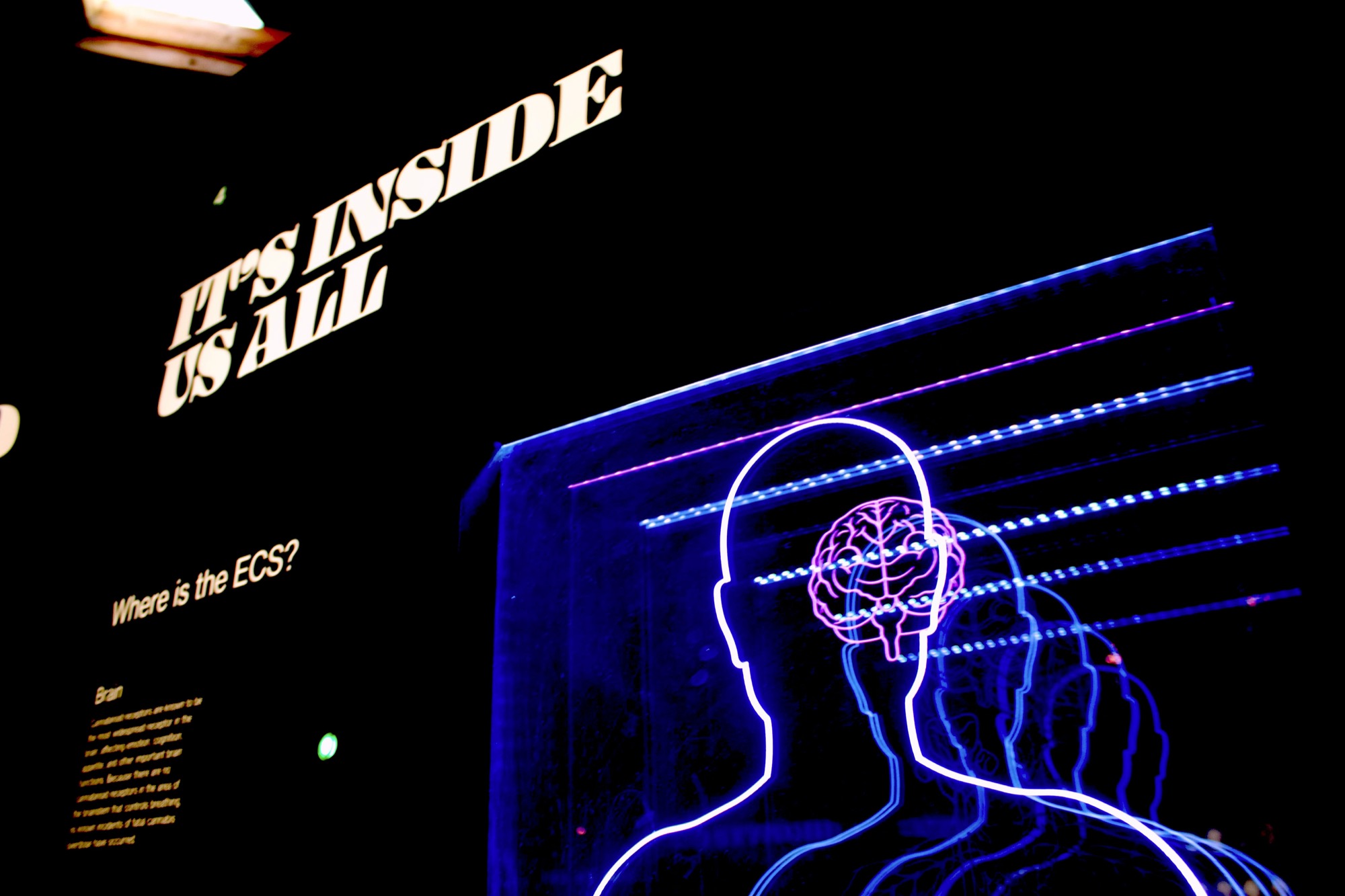

Naukowcy Apple opracowali nową metodę szkolenia dużych modeli językowych (LLM), która płynnie integruje zarówno informacje tekstowe, jak i wizualne.

Odkrycia firmy, wyszczególnione w artykule badawczym zatytułowanym „MM1: Methods, Analysis & Insights from Multimodal LLM Pre-training”, prezentują nowe podejście do tworzenia bardziej inteligentnych i elastycznych systemów sztucznej inteligencji. Wykorzystując zróżnicowany zbiór danych obejmujący pary obrazów z podpisami, przeplatane dokumenty tekstowo-obrazowe i dane tekstowe, Apple twierdzi, że model MM1 wyznacza nowy standard w zakresie zdolności sztucznej inteligencji do wykonywania zadań, takich jak podpisy obrazów, odpowiadanie na pytania wizualne i wnioskowanie w języku naturalnym z wysokim poziomem dokładności.

Badania Apple koncentrują się na połączeniu różnych typów danych szkoleniowych i architektur modeli, co umożliwia sztucznej inteligencji rozumienie i generowanie języka w oparciu o mieszankę wskazówek wizualnych i językowych. Zdolność ta ma kluczowe znaczenie dla zadań wymagających zniuansowanego rozumienia świata, takich jak interpretacja złożonych obrazów lub odpowiadanie na pytania zawierające elementy wizualne.

W artykule podkreślono również wyjątkowe zdolności modelu MM1 do uczenia się w kontekście, szczególnie w największej konfiguracji modelu z 30 miliardami parametrów. Wersja ta najwyraźniej wykazuje niezwykłe zdolności do wieloetapowego rozumowania na wielu obrazach przy użyciu kilkukrotnych podpowiedzi „łańcucha myśli”, techniki, która pozwala sztucznej inteligencji na rozwiązywanie złożonych, otwartych problemów w oparciu o minimalne przykłady.

iOS 18 będzie w znacznym stopniu przeprojektowany, a na macOS poczekamy dłużej