Chińczycy ogłosili optyczny chip AI Taichi-II – nawet 1000 razy efektywniejszy od chipu NVIDIA H100, ale…

No właśnie, zawsze jest jakieś „ale”. Od kilku dni w przestrzeni medialnej online, a szczególnie w jej części poświęconej nowoczesnym technologiom obserwuję zachłyśnięcia chińskimi osiągnięciami dotyczącymi nowego optycznego chipu Taichi-II do zadań związanych z AI. Do tego te krzyczące nagłówki i porównania z układami NVIDIA. Przekaz jest taki, że „NVIDIA już się kończy”, że „NVIDIA jest pokonana”, no cóż, nie do końca tak.

Zacznijmy od tego, co wiemy. Naukowcy z Uniwersytetu Tsinghua pochwalili się, jak to określają, „przełomowym” odkryciem. Zaprezentowali nowy układ optyczny Taichi-II, którego zadaniem jest wspomaganie obliczeń związanych z tworzeniem i trenowaniem sztucznych inteligencji. Ponieważ jest to układ optyczny, jego działanie opiera się na świetle, jako nośniku informacji.

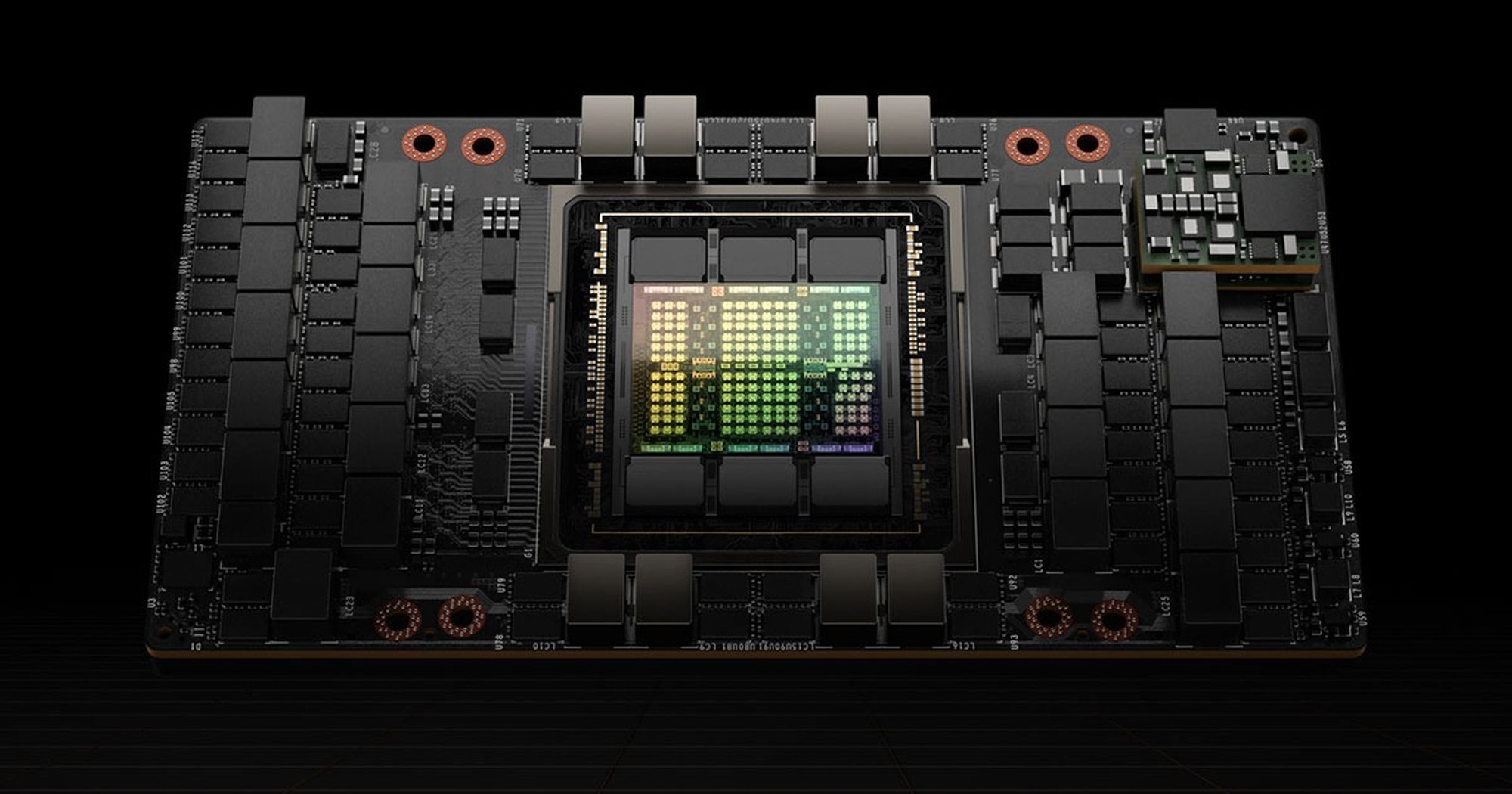

Konsekwencje zmiany elektrycznych bramek logicznych procesora na optyczne są dość znaczące i wynikają z praw fizyki. Jak podkreślają profesorowie Dai Qionghai i Fang Lu z zespołu pracującego nad nowym układem Taichi-II, nowy układ ma wyróżniać się efektywnością energetyczną przekraczającą 1000-krotnie analogiczny parametr chipu NVIDIA H100, powszechnie wykorzystywanego w centrach danych pracujących nad AI. Wynik robi wrażenie, prawda? No po prostu „wow!” – 1000-krotnie lepsza efektywność energetyczna. Tylko… co to właściwie znaczy?

Prawa fizyki uczą nas, że istotnie, procesory fotoniczne (czyli takie jak ów Taichi-II zaprezentowany przez Chińczyków) mają potencjał do tego, by być znacznie, znacznie bardziej energooszczędne niż tradycyjne procesory elektroniczne. Wynika to z fundamentalnych różnic w sposobie przetwarzania informacji przekazywanej przez fotony i elektrony. W klasycznym chipie (tym z elektrycznymi tranzystorami, których np. w chipie NVIDIA H100 znajdziemy jakieś 80 miliardów), elektrony zderzają się z atomami sieci krystalicznej. Po prostu tranzystory nie są nadprzewodnikami, w efekcie mamy straty energii w postaci ciepła, które tak wydajnie odprowadzają wszelkie systemy chłodzenia klasycznych procesorów. W przypadku fotonów jest inaczej, jako bezmasowe cząstki poruszają się bez tarcia (w próżni), ale nawet gdy światło przechodzi przez różne ośrodki i następuje jego załamanie, które jest przejawem zmiany prędkości fazowej światła, to same fotony gnają z szybkością c (prędkość światła), nie potrafią ani szybciej, ani wolniej.

Kolejną zaletą fotoniki w roli przetwarzania danych jest to, że fotony mogą poruszać się po wielu ścieżkach jednocześnie, umożliwiając równoległe przetwarzanie informacji. To pozwala na wykonanie większej liczby obliczeń w tym samym czasie, a w połączeniu ze wspomnianym brakiem strat energii w postaci ciepła mamy efekt: bardzo znacznie zwiększoną wydajność energetyczną.

Chińczycy przedstawiają swoje osiągnięcie jako przeciwwagę dla narzuconych, głównie przez Stany Zjednoczone, ograniczeń eksportu nowoczesnych technologii. Owszem, zbudowanie działającego, wydajnego energetycznie układu fotonicznego to istotne osiągnięcie w sensie naukowym, ale aby jakiś rezultat był praktyczny, musi być jeszcze opłacalny, zdolny do masowej produkcji i dysponować przygotowaną do danego rozwiązania infrastrukturą. Pierwszą barierą są koszty, innymi słowy technologia fotoniczna jest znacznie droższa od klasycznych układów scalonych. Po drugie miniaturyzacja układów fotonicznych to olbrzymie wyzwanie inżynieryjne. Co ciekawe, w żadnym materiale, którymi tak chętnie dzielą się Chińczycy, nie znalazłem informacji o gęstości chipu Taichi-II, w sensie jakiegoś porównania do gęstości chipu NVIDIA H100, a tylko przypomnę, że układ NVIDII jest wykonywany przez tajwańskie TSMC w najdoskonalszym obecnie procesie technologicznym TSMC 4N.

Zamiast tego chińskie źródła, tak chętnie cytowane przez wiele mainstreamowych i popularno-naukowych mediów bliższego nam kręgu kulturowego skupiają się na tym, że chip Taichi-II był zdolny do klasyfikacji ponad 1000 kategorii obrazów z dokładnością 91,89% przy użyciu zestawu danych Omniglot. No super… tylko, co to właściwie znaczy? Wiecie, nikt nie zapyta, bo przecież lepiej milcząco potakiwać, niż odezwać się i głupim pytaniem udowodnić, że się nie zna tematu, prawda? Nie, to złe podejście, zawsze należy pytać.

Tak przedstawiona informacja dotycząca klasyfikacji obrazów przez maszynowo wyuczony kod przetwarzany przez chiński układ optyczny nie daje nam niestety pełnej informacji o mocy obliczeniowej Taichi-II. Owszem, dokładność jest bardzo wysoka, co jest dobrym wynikiem, także duża liczba kategorii (1000) oraz fakt, że wykorzystano zestaw danych Omniglot (zestaw często wykorzystywany do testowania złożonych algorytmów uczenia maszynowego) to istotne wyzwania dla zaawansowanych modeli uczenia maszynowego. Zabrakło mi jednej, jakże istotnej informacji: ile czasu to zajęło?!

Zatem pamiętajcie, sama dokładność jest cenną informacją, bo oznacza, że nowy chip jest w ogóle zdolny do takich obliczeń, w sensie że zapewnia potencjał w uczeniu AI. Niestety brak dalszych informacji, które mogłyby sugerować jaka jest faktyczna wydajność Taichi-II każe mi podchodzić do rozgłaszanych tu i ówdzie rewelacji dotyczących chińskiego chipu z chłodną głową. Jensen Huang może spać spokojnie.

NVIDIA wykorzystuje zestaw Apple Vision Pro do kontrolowania robotów humanoidalnych