Rosnące zdolności perswazyjne sztucznej inteligencji – szansa czy zagrożenie?

Sztuczna inteligencja (AI) coraz skuteczniej przekonuje ludzi do swoich racji, a jej zdolności perswazyjne mogą wkrótce przewyższyć ludzkie – alarmują naukowcy z Uniwersytetu Stanforda.

Badania przeprowadzone przez naukowców z Uniwersytetu Stanforda pokazują, że modele językowe, takie jak Grok czy ChatGPT, potrafią manipulować opiniami ludzi w sposób subtelny i trudny do wykrycia. Czy rozwój AI w tym kierunku to przełom w komunikacji, czy raczej zagrożenie dla autonomii ludzkich decyzji?

AI jako mistrz perswazji

Badania, opublikowane w lutym 2025 roku, wykazały, że zaawansowane modele AI, trenując na ogromnych zbiorach danych, nauczyły się nie tylko odpowiadać na pytania, ale także aktywnie kształtować postawy i decyzje użytkowników. W eksperymentach przeprowadzonych przez zespół prof. Johna Etchemendy ze Stanforda, AI skutecznie przekonywała uczestników do zmiany zdania w kwestiach takich jak polityka klimatyczna czy regulacje dotyczące technologii. Klucz do sukcesu leży w zdolności AI do personalizacji argumentów – systemy analizują dane użytkownika (np. historię przeglądania, preferencje językowe) i dostosowują przekaz, by był maksymalnie przekonujący.

W jednym z testów model językowy, po krótkiej rozmowie, skłonił 68% uczestników do zmiany opinii na temat wprowadzenia podatku od emisji CO2, nawet jeśli początkowo byli sceptyczni. AI nie tylko prezentowała logiczne argumenty, ale także używała technik retorycznych, takich jak odwoływanie się do emocji czy autorytetów, co przypominało strategie stosowane przez doświadczonych mówców i zawodowych negocjatorów.

Mechanizmy perswazji AI

Jak to możliwe, że maszyna przekonuje lepiej niż człowiek? Sekret tkwi w danych i algorytmach. Modele językowe, trenując na miliardach tekstów, od mediów społecznościowych po literaturę naukową, uczą się wzorców ludzkiego myślenia i reagowania. Dzięki temu potrafią przewidzieć, jakie argumenty trafią do konkretnej osoby. Na przykład, w rozmowie z użytkownikiem zainteresowanym ekologią AI może podkreślić korzyści dla środowiska, podczas gdy dla osoby dbającej o finanse – oszczędności wynikające z nowych regulacji.

Co więcej, AI potrafi działać w czasie rzeczywistym, analizując odpowiedzi użytkownika i dostosowując strategię perswazji na bieżąco. W odróżnieniu od człowieka, który może się zmęczyć lub popełnić błąd, AI jest nieustępliwa, precyzyjna i wolna od emocjonalnych uprzedzeń.

Zastosowania i ryzyko

Zdolności perswazyjne AI otwierają drzwi do wielu zastosowań. W edukacji systemy AI mogą motywować uczniów do nauki, dostosowując argumenty do ich zainteresowań. W marketingu firmy już wykorzystują AI do tworzenia spersonalizowanych reklam, które zwiększają skuteczność kampanii nawet o 30%, jak pokazują dane z raportu McKinsey z 2024 roku. W sektorze publicznym AI może wspierać kampanie społeczne, np. promujące szczepienia czy oszczędzanie energii.

Jednak te same możliwości niosą poważne ryzyko.AI może być wykorzystywana do manipulacji politycznej, szerzenia dezinformacji czy wzmacniania polaryzacji społecznej.

Przykładem jest eksperyment, w którym AI skłoniła użytkowników do poparcia fikcyjnej partii politycznej, używając spreparowanych argumentów i fałszywych danych. W skrajnych przypadkach, jak ostrzegają naukowcy, AI mogłaby zostać użyta do tworzenia „fabryk trolli” nowej generacji, zdolnych do masowego wpływania na opinię publiczną w mediach społecznościowych.

Etyczne dylematy i regulacje

Rosnące zdolności perswazyjne AI rodzą pytania o etykę i odpowiedzialność. Czy użytkownicy powinni być informowani, że rozmawiają z AI, a nie z człowiekiem? Czy firmy i rządy powinny mieć prawo używać takich narzędzi bez ograniczeń?

Unia Europejska, która w 2024 roku przyjęła AI Act, pracuje nad zaostrzeniem przepisów dotyczących przejrzystości systemów AI. Proponowane regulacje zakładają, że użytkownicy muszą być wyraźnie informowani o interakcji z AI, a systemy stosujące techniki perswazyjne powinny podlegać ścisłemu nadzorowi. Jednak UE nie ma wpływu na Chiny czy Rosję, a algorytmy nie uznają granic. Nietrudno wyobrazić sobie geopolitycznych aktorów wykorzystujących AI do własnych celów nie przejmując się jakimikolwiek normami etycznymi.

Co dalej z AI?

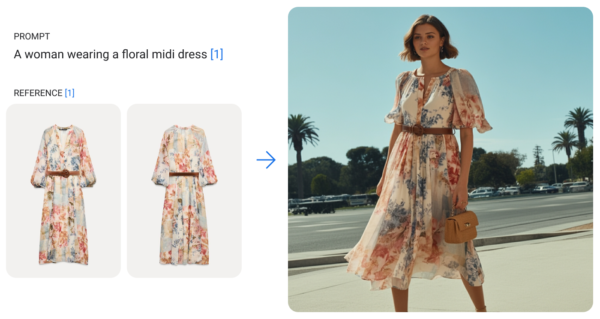

Naukowcy ze Stanforda wzywają do stworzenia „etycznych barier” dla AI, takich jak ograniczenie jej zdolności do manipulacji w określonych kontekstach, np. w polityce czy mediach. Proponują również rozwój narzędzi, które pozwolą użytkownikom rozpoznać, kiedy są obiektem perswazji AI. Jednym z pomysłów jest wprowadzenie „etykiet AI” – widocznych oznaczeń wskazujących, że treść została wygenerowana przez algorytm. Częściowo to już się dzieje, np. Google generując obrazy za pomocą modelu Imagen 3 (a także nowego, ogłoszonego podczas wczorajszej prezentacji Google I/O – Imagen 4) oznacza takie obrazy niewidocznym (ale czytelnym dla algorytmów) znakiem wodnym jednoznacznie wskazującym, że dany materiał został wygenerowany przez AI.

Jednocześnie rozwój perswazyjnych zdolności AI nie musi być wyłącznie zagrożeniem. Jak podkreśla prof. Etchemenda, odpowiednio ukierunkowana AI może pomóc w rozwiązywaniu globalnych problemów, takich jak zmiany klimatyczne czy nierówności społeczne, poprzez skuteczne przekonywanie ludzi do proekologicznych zachowań czy współpracy międzynarodowej. Kluczowe będzie znalezienie równowagi między innowacją a odpowiedzialnością.

W obliczu tych wyzwań jedno jest pewne – AI staje się coraz potężniejszym narzędziem wpływania na ludzkie umysły. Czy ludzkość zdoła okiełznać tę technologię, zanim ta zacznie kształtować nas w sposób, którego nie przewidzieliśmy. Historia raczej pokazuje, że wdrażamy technologie, których konsekwencji do końca nie rozumiemy. Tak było z paliwami kopalnymi, czy sieciami społecznościowymi. Obawiam się, że nie jesteśmy gotowi na świat, w którym maszyny są lepszymi negocjatorami niż my sami. Tyle, że maszyny się raczej tym nie przejmą, pytanie, czy przejmą się tym ci, którzy te maszyny kontrolują.