Naukowcy znaleźli sposób na deepfake’i. Ukryli tajny kod w świetle

W czasach, gdy wygenerowanie fałszywego wideo jest łatwiejsze niż kiedykolwiek, a odróżnienie go od prawdy graniczy z cudem, naukowcy z Cornell University zaprezentowali przełomową technologię, która może stać się nową bronią w walce z dezinformacją.

Ich metoda polega na ukrywaniu cyfrowego znaku wodnego bezpośrednio w świetle oświetlającym nagrywaną scenę.

„Kiedyś wideo traktowano jako źródło prawdy, ale nie możemy już dłużej wychodzić z takiego założenia” – powiedział współautor badania, Abe Davis z Cornell University. Problem polega na tym, że twórcy fałszywych nagrań mają fundamentalną przewagę: równy dostęp do autentycznych materiałów wideo i zaawansowanych, tanich narzędzi do edycji, które uczą się na ogromnych zbiorach danych, czyniąc fałszywki niemal nieodróżnialnymi od oryginału.

Asymetria informacji – klucz do walki z fałszywkami

Aby skutecznie wykrywać manipulacje, techniki kryminalistyczne muszą opierać się na tzw. asymetrii informacji – muszą dysponować danymi, których fałszerz nie posiada i których nie da się odtworzyć z publicznie dostępnych materiałów.

Istniejące metody, takie jak cyfrowe znaki wodne czy sumy kontrolne plików, często okazują się niewystarczające. Suma kontrolna może wykryć zmianę w pliku, ale nie odróżni standardowej kompresji wideo od złośliwej edycji, polegającej na wstawieniu wirtualnych obiektów.

Jak działa „kodowanie w świetle”?

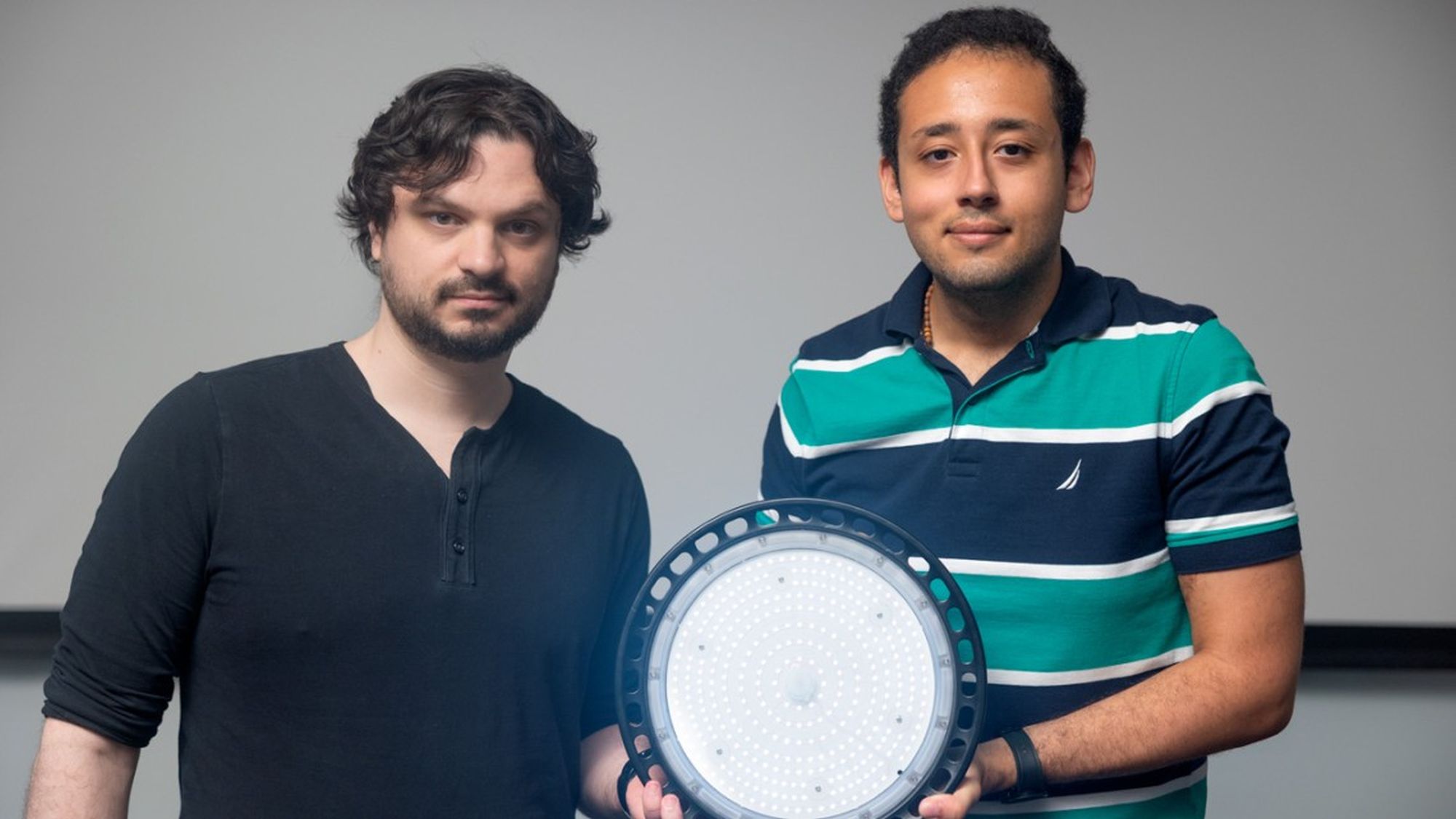

Nowa metoda, nazwana „noise-coded illumination” (NCI), rozwiązuje te problemy, ukrywając znak wodny w czymś, co wygląda jak zwykły „szum” źródła światła. Zmiany te są niewidoczne dla ludzkiego oka, ale mogą być odczytane przez odpowiednie oprogramowanie. Można je wprowadzić do oświetlenia w pomieszczeniu lub za pomocą małego chipa podłączonego do lampy.

Każdy taki znak wodny przenosi ukrytą, niskiej jakości wersję niemodyfikowanego wideo, nazwaną przez naukowców „wideo kodowym” („code video”). „Gdy ktoś zmanipuluje wideo, jego zmienione fragmenty zaczynają być sprzeczne z tym, co widzimy w tych filmach kodowych, co pozwala nam zobaczyć, gdzie dokonano zmian” – wyjaśnia Davis. Jeśli ktoś spróbuje wygenerować całkowicie fałszywe wideo przy użyciu AI, ukryte w nim wideo kodowe będzie wyglądać jak losowe wariacje, co również zdemaskuje fałszerstwo.

Technika okazała się odporna na szeroką gamę manipulacji, w tym deepfake, zmiany prędkości, a także na różne warunki nagrywania, takie jak ruch kamery, lampa błyskowa, różny stopień kompresji wideo czy filmowanie wewnątrz i na zewnątrz. Co najważniejsze, nawet jeśli fałszerz wie, że technika jest używana, jego zadanie staje się niewspółmiernie trudniejsze. „Zamiast fałszować światło dla jednego wideo, musi sfałszować każde wideo kodowe osobno, a wszystkie te fałszywki muszą być ze sobą zgodne” – dodaje Davis.

Zainteresowanych szczegółami dotyczącymi pracy wspomnianych badaczy odsyłam do artykułu w zasobach Arxiv.