Apple ujawnia trzy kluczowe badania z konferencji o prywatności i sztucznej inteligencji

Apple opublikowało prezentacje z Workshop on Privacy-Preserving Machine Learning (20–21 marca 2025), poświęconego prywatności i bezpieczeństwu w rozwoju AI.

Kilka miesięcy temu Apple zorganizowało warsztaty na temat uczenia maszynowego z zachowaniem prywatności, podczas których przedstawiono prezentacje i dyskusje na temat prywatności, bezpieczeństwa i innych kluczowych obszarów odpowiedzialnego rozwoju uczenia maszynowego. Teraz prezentacje te zostały upublicznione.

Podobnie jak niedawno w przypadku prezentacji z 2024 Workshop on Human-Centered Machine Learning, Apple opublikowało post na swoim blogu Machine Learning Research z kilkoma filmami i długą listą badań i artykułów, które zostały zaprezentowane podczas dwudniowego wydarzenia hybrydowego, które odbyło się w dniach 20-21 marca 2025 roku.

Do trzech najważniejszych prac należy zaliczyć.

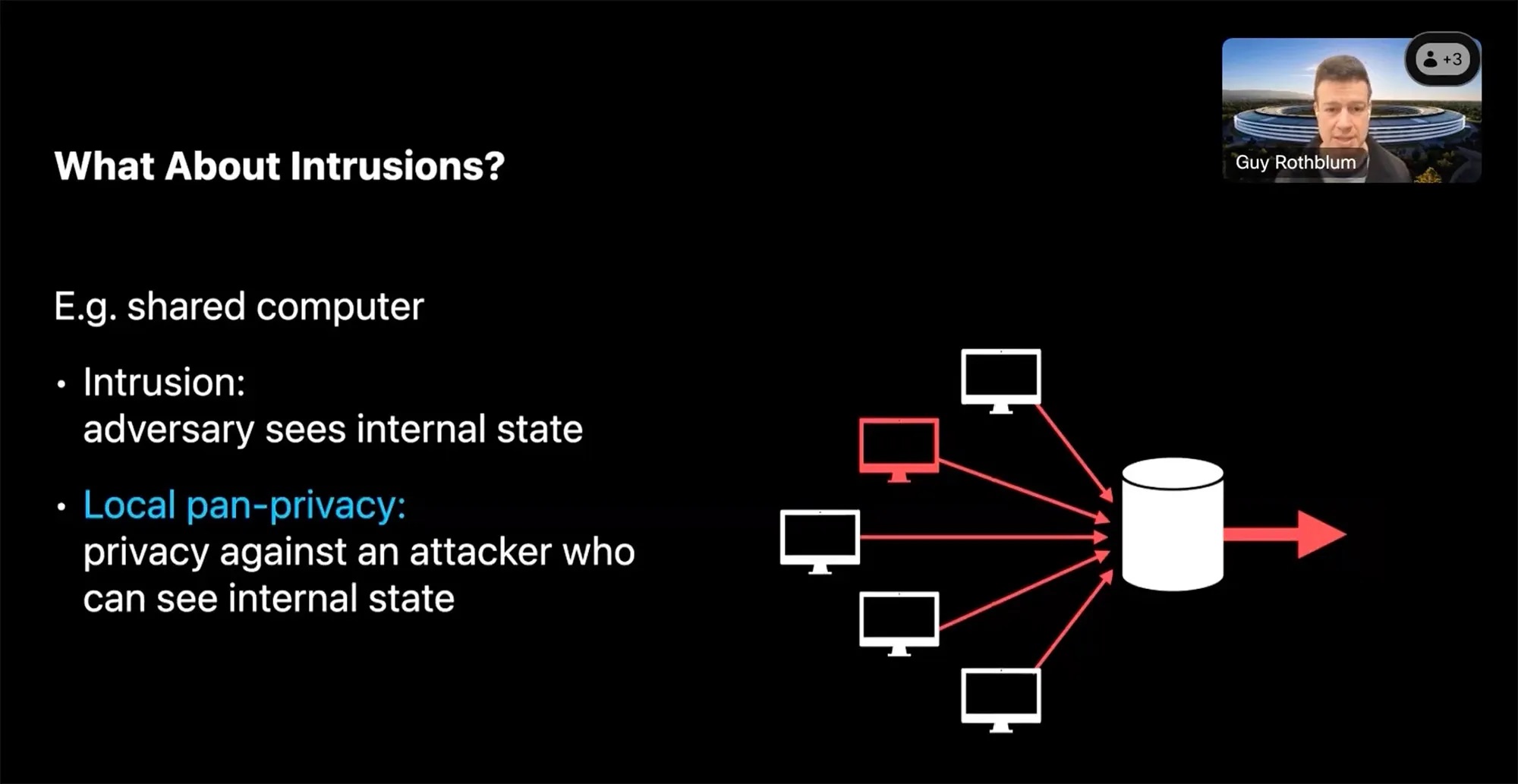

Local Pan-Privacy for Federated Analytics – badanie Apple pokazuje, jak chronić prywatność danych nawet wtedy, gdy urządzenie zostanie wielokrotnie skompromitowane. Zastosowano nowe szyfrowane metody pozwalające zbierać statystyki bez ujawniania aktywności użytkownika.

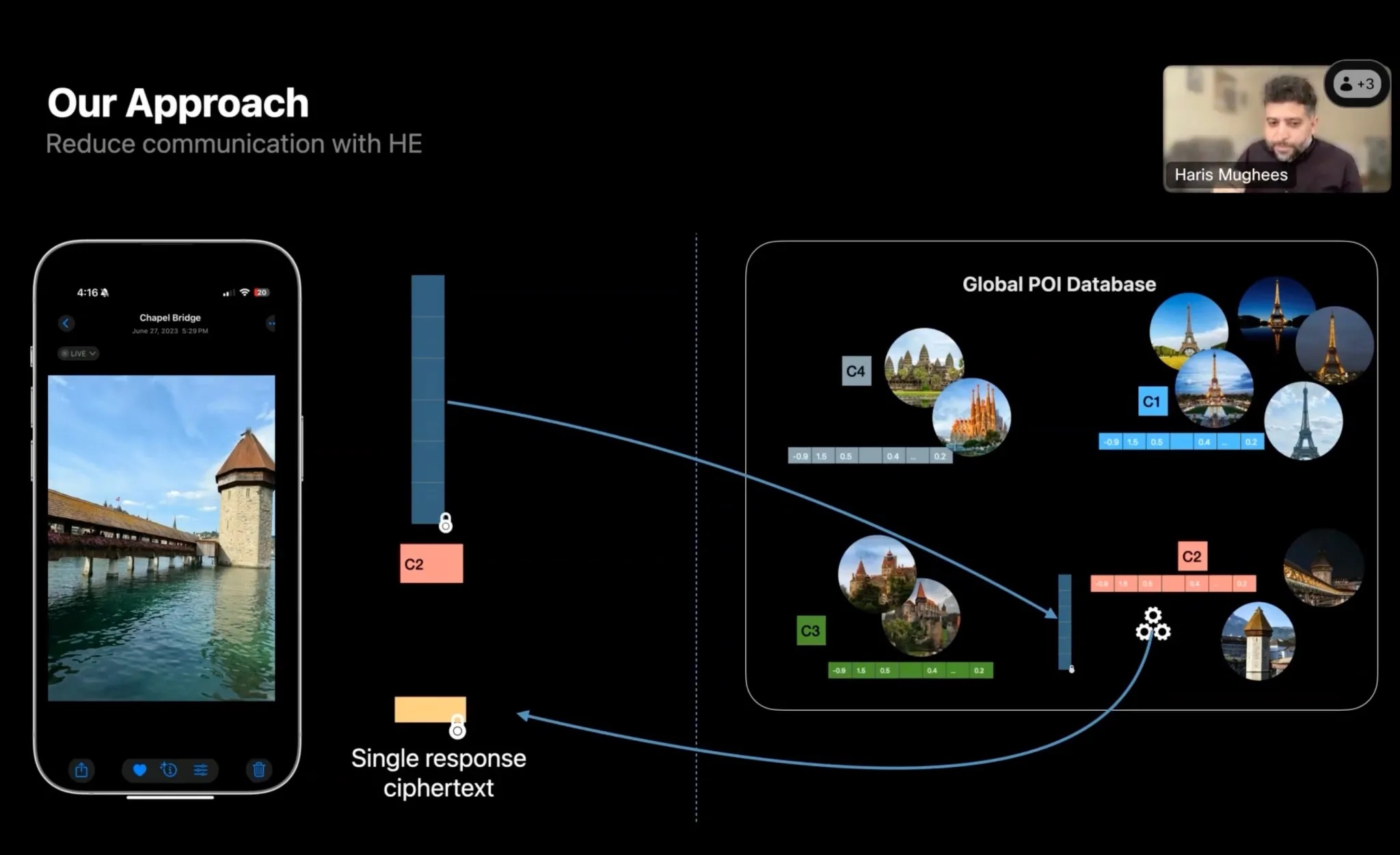

Scalable Private Search with Wally – Apple zaprezentowało system wyszukiwania z wykorzystaniem differential privacy. Mechanizm Wally dodaje do zapytania losowe dane, co zapewnia anonimowość użytkowników, a jednocześnie umożliwia obsługę milionów żądań przy niższych kosztach.

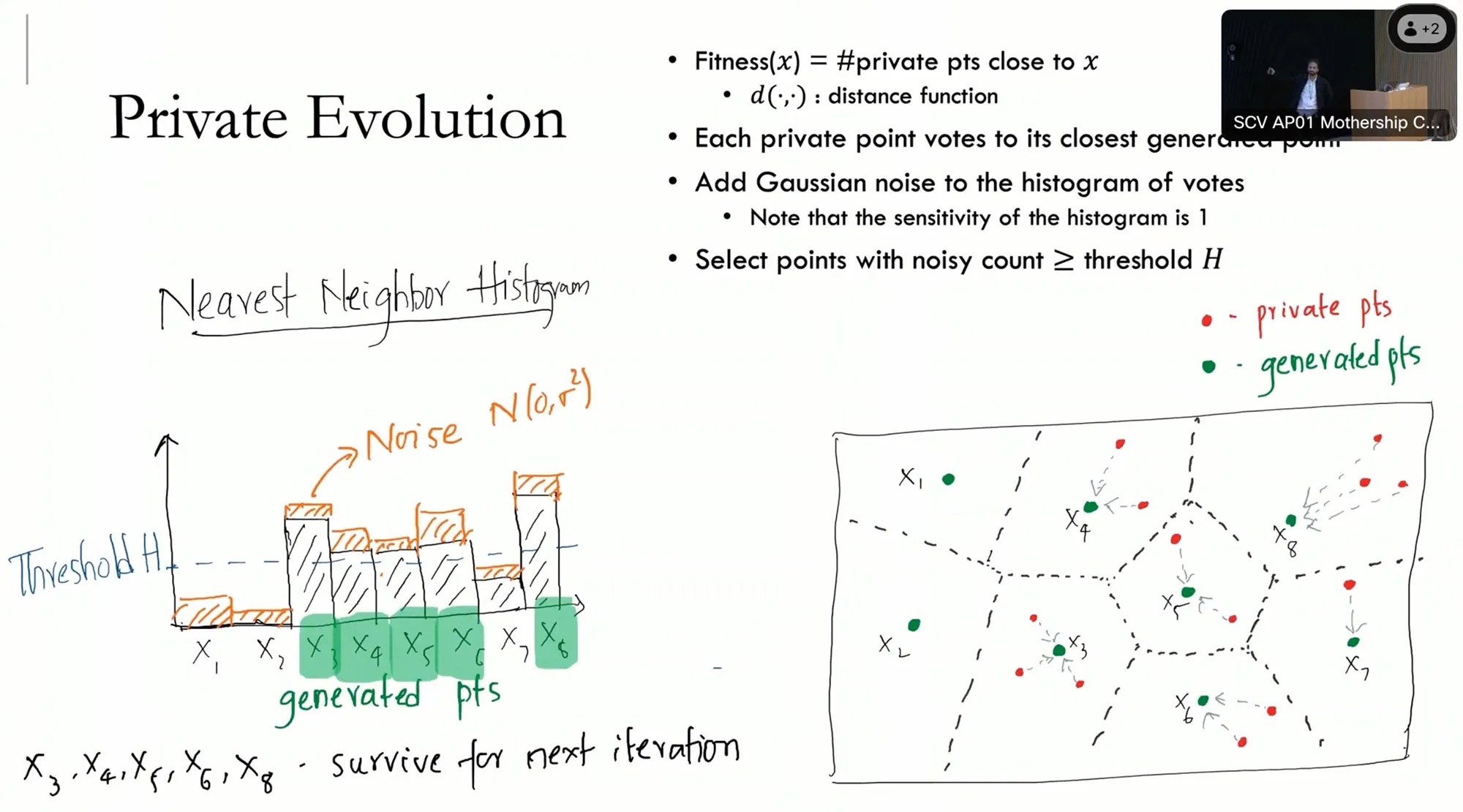

Differentially Private Synthetic Data via Foundation Model APIs – badanie Microsoftu pokazuje, jak generować syntetyczne dane na podstawie modeli foundation, zachowując wartość danych rzeczywistych, ale bez naruszania prywatności.

Łącznie udostępniono 25 publikacji, przygotowanych przez badaczy z Apple, Microsoftu, Google oraz czołowych uczelni (m.in. MIT, UC Berkeley, Carnegie Mellon).

Oto ich pełna lista:

- AirGapAgent: Protecting Privacy-Conscious Conversational Agents

- A Generalized Binary Tree Mechanism for Differentially Private Approximation of All-Pair Distances

- Differentially Private Synthetic Data via Foundation Model APIs 1: Images

- Differentially Private Synthetic Data via Foundation Model APIs 2: Text

- Efficient and Near-Optimal Noise Generation for Streaming Differential Privacy

- Elephants Do Not Forget: Differential Privacy with State Continuity for Privacy Budget

- Improved Differentially Private Continual Observation Using Group Algebra

- Instance-Optimal Private Density Estimation in the Wasserstein Distance

- Leveraging Model Guidance to Extract Training Data from Personalized Diffusion Models

- Local Pan-privacy for Federated Analytics

- Nearly Tight Black-Box Auditing of Differentially Private Machine Learning

- On the Price of Differential Privacy for Hierarchical Clustering

- Operationalizing Contextual Integrity in Privacy-Conscious Assistants

- PREAMBLE: Private and Efficient Aggregation via Block Sparse Vectors

- Privacy amplification by random allocation

- Privacy of Noisy Stochastic Gradient Descent: More Iterations without More Privacy Loss

- Privately Estimating a Single Parameter

- Scalable Private Search with Wally

- Shifted Composition I: Harnack and Reverse Transport Inequalities

- Shifted Interpolation for Differential Privacy

- Tractable Agreement Protocols

- Tukey Depth Mechanisms for Practical Private Mean Estimation

- User Inference Attacks on Large Language Models

- Universally Instance-Optimal Mechanisms for Private Statistical Estimation

- “What do you want from theory alone?” Experimenting with Tight Auditing of Differentially Private Synthetic Data Generation