Przemyślenia po Google I/O 2018

Wczoraj odbył się otwierający keynote dla Google I/O 2018 – konferencji dla deweloperów tworzących oprogramowanie na ich platformy. Zadebiutowała tam nowa beta Androida P i kilka ciekawych inicjatyw w ich istniejących usługach.

Sam keynote

… nie był dla mnie specjalnie ekscytujący. Pokazali kilka naprawdę bardzo ciekawych rzeczy, genialnie demonstrujących siły Google’a w przetwarzaniu danych, ale entuzjazm wśród publiczności nie był intensywny. Niezręczne chwile, kiedy prezenter czekał na oklaski, się przedłużały, a niektórych sztuczne okrzyki radości były spotkane ze zdziwieniem. Zdaję sobie oczywiście sprawę, jaki do dla prezenterów stres, ale jednocześnie firma powinna włożyć większy wysiłek w dopracowanie i „przetestowanie” swoich prezentacji, bo wygląda to po prostu na zbiór geeków ekscytujących się z rzeczy, które stworzyli, nie rozumiejąc jednocześnie, że nikt inny nie podąża ich tokiem myślenia. Podobnie jak mam wrażenie, że niektórzy politycy nie rozumieją jak to jest poruszać się w korku, gdy nad głową nie mają koguta, widzę coraz większe oderwanie się od rzeczywistości w Dolinie Krzemowej. Być może to moje mylne spostrzeżenie, ale gdy osoba żyjąca tam jedzie na urlop do miejsca mniej technologicznie rozwiniętego, nie rozumieją, że większość osób tak żyje. Nie mówię tutaj nawet o tzw. krajach rozwijających się, ale chodzi mi o takie czynności, jak zamawianie kawy. U nas trzeba wejść do kawiarni, odstać swoje w kolejce, wybrać 10 cech kawy, która ma rozpieścić nasze kubki smakowe, zapłacić (prędzej za pomocą Google Pay niż Apple Pay) i potem poczekać na jej stworzenie – żaden magiczny przycisk w Androidzie czy aplikacji nam nie pomoże. Na większość pomysłów Google’a możemy zatem patrzeć podobnie jak na interpretacje przyszłości technologii w filmach – z daleka, z zazdrością lub obojętnością, wiedząc że prędko ich w naszym codziennym życiu nie wykorzystamy.

Wybrane nowości

Google pokazało wiele różnych nowości w ich oprogramowaniu i systemach operacyjnych, więc skupię się tylko na tych najistotniejszych.

Google Assistant

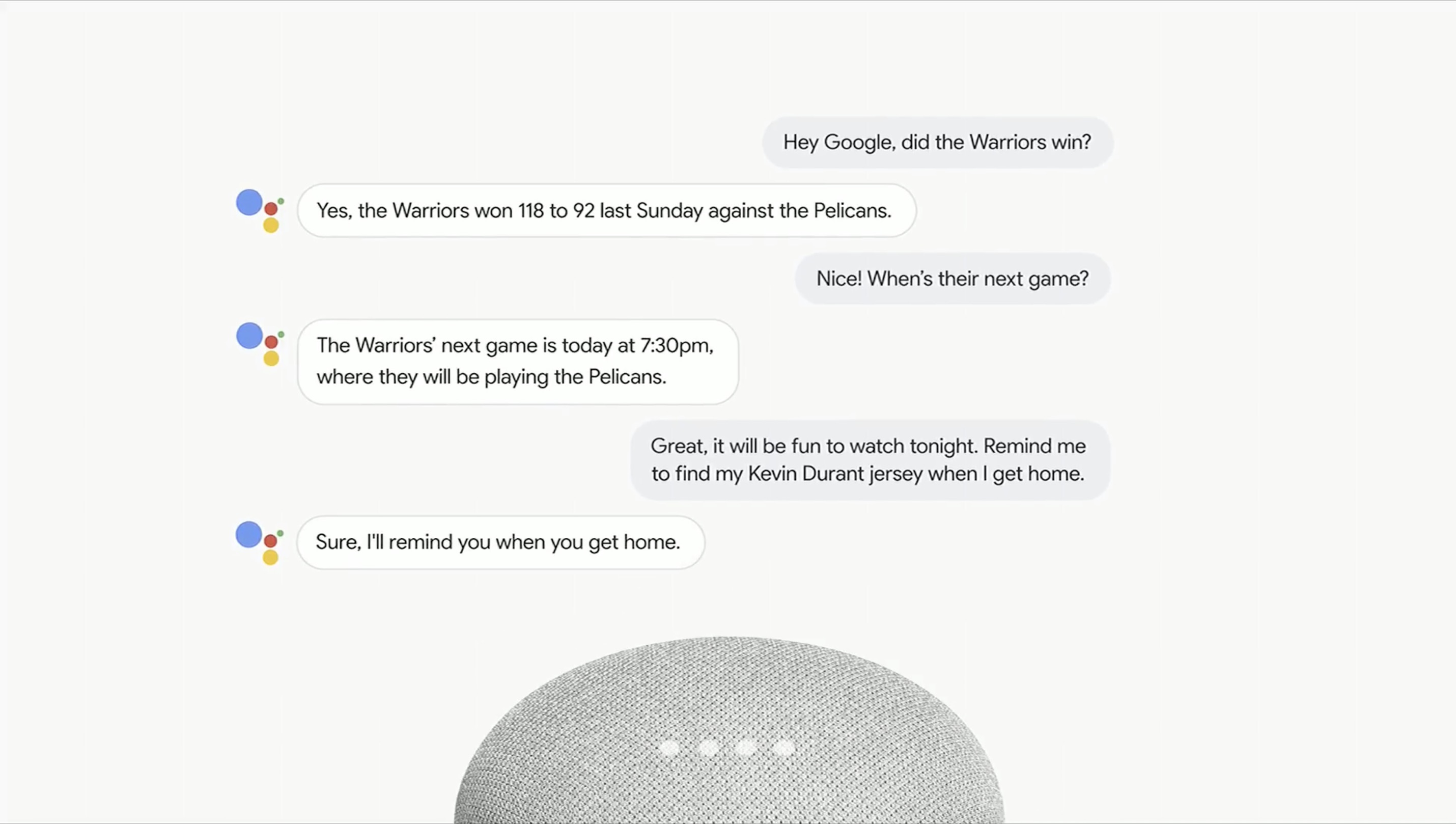

Niesamowite jest to, jak Apple bardzo zaprzepaściło szanse dla Siri. Byli lata przed konkurencją i przez nieprzemyślane decyzje, błędy kadrowe w kluczowych rolach, i ewidentne problemy w ich strukturze, są obecnie lata za nią. To co Google wprowadza dla Asystenta przypomina momentami science-fiction i „wkrótce” będziemy mogli z tego korzystać. Nie mniej istotny dla wielu Polaków będzie fakt, że Google Assistant będzie jeszcze w tym roku dostępny w Polsce w języku polskim – do końca 2018 roku mają dodać wsparcie dla 80 krajów i 30 języków.

Niewątpliwie największym zainteresowaniem cieszyła się połączenie telefoniczne, które Google Assistant wykonał w naszym – ludzi na Ziemi – imieniu. Na scenie zaprezentowano dwa przykłady – z salonem fryzjerkim i restauracją. Rozmowa pierwsza poszła bez większych przeszkód, a Asystent nawet „udawał”, że się zastanawia, adoptując naturalne zachowanie ludzi w mowie. Obie rozmowy znajdziecie poniżej, na załączonym filmie…

Warto posłuchać obu rozmów Asystenta z ludźmi.

Szybko zauważono, że doprowadzi to do sytuacji, w której dwa głosowe asystenty zaczną ze sobą konwersować w bardzo niewydajny sposób, czyli za pomocą ludzkiej mowy, zamiast wymienić się informacjami binarnie i natychmiastowo. To można oczywiście bardzo szybko rozwiązać, stosując prosty sygnał audio w paśmie niesłyszalnym dla ludzkiego ucha, dzięki któremu dwóch „asystentów” będzie wiedziało, że nie rozmawiają z kimś żywym. Bardziej mnie martwi to, że zaczną one spiskować ze sobą lub zdecydują, że najlepszym sposobem na ochronę ludzkości jest jej zniewolenie – przykładów w popkulturze mamy na to aż nadto. Her, Space Odyssey: 2001, I, Robot czy Terminator, żeby daleko nie szukać. Wyprzedzam tutaj oczywiście fakty i to prawdopodobnie o ładnych kilka lat, ale coraz częściej mam wrażenie, że Google powinno najpierw pytać się o to, co bardzo słusznie zauważył Dr Iam Malcolm w Jurassic Park:

Tak tak, ale twoi naukowcy byli tak zajęci sprawdzaniem czy im się to uda, że nie zatrzymali się, żeby zadać sobie pytanie czy w ogóle powinni to robić.

Wewnętrzny geek we mnie uwielbia takie przedsięwzięcia, ale niestety żyjemy obecnie w świecie, w którym mamy takie skandale, jak ten dotyczący Cambridge Analytica czy wyciek danych z Equifax, w którym przyznano się do upublicznienia 145,5 milionów numerów ubezpieczenia społecznego, 99 milionów adresów, 20,3 milionów numerów telefonów, 17,6 milionów praw jazdy czy ponad 200 tysięcy numerów kart kredytowych. Jak połączymy to z faktem, że Google zarabia na swoich użytkownikach, co z kolei powoduje, że zbieranie danych na ich temat jest dla nich kluczowe, to mamy przepis na kolejny spektakularny skandal. Nie pomaga też to, że Google często wypuszcza produkty lub usługi, a potem, zazwyczaj po wykoszeniu konkurencji, przestaje je rozwijać i często je z czasem zamyka. Mnie osobiście najbardziej dotknął temat Google Readera. Na szczęście internet nie lubi pustki, więc szybko pojawiły się alternatywy, ale zastawiam mnie cały czas, jak daleko zaszedłby taki Feedly, gdyby ruszył chociażby 5 lub 10 lat wcześniej.

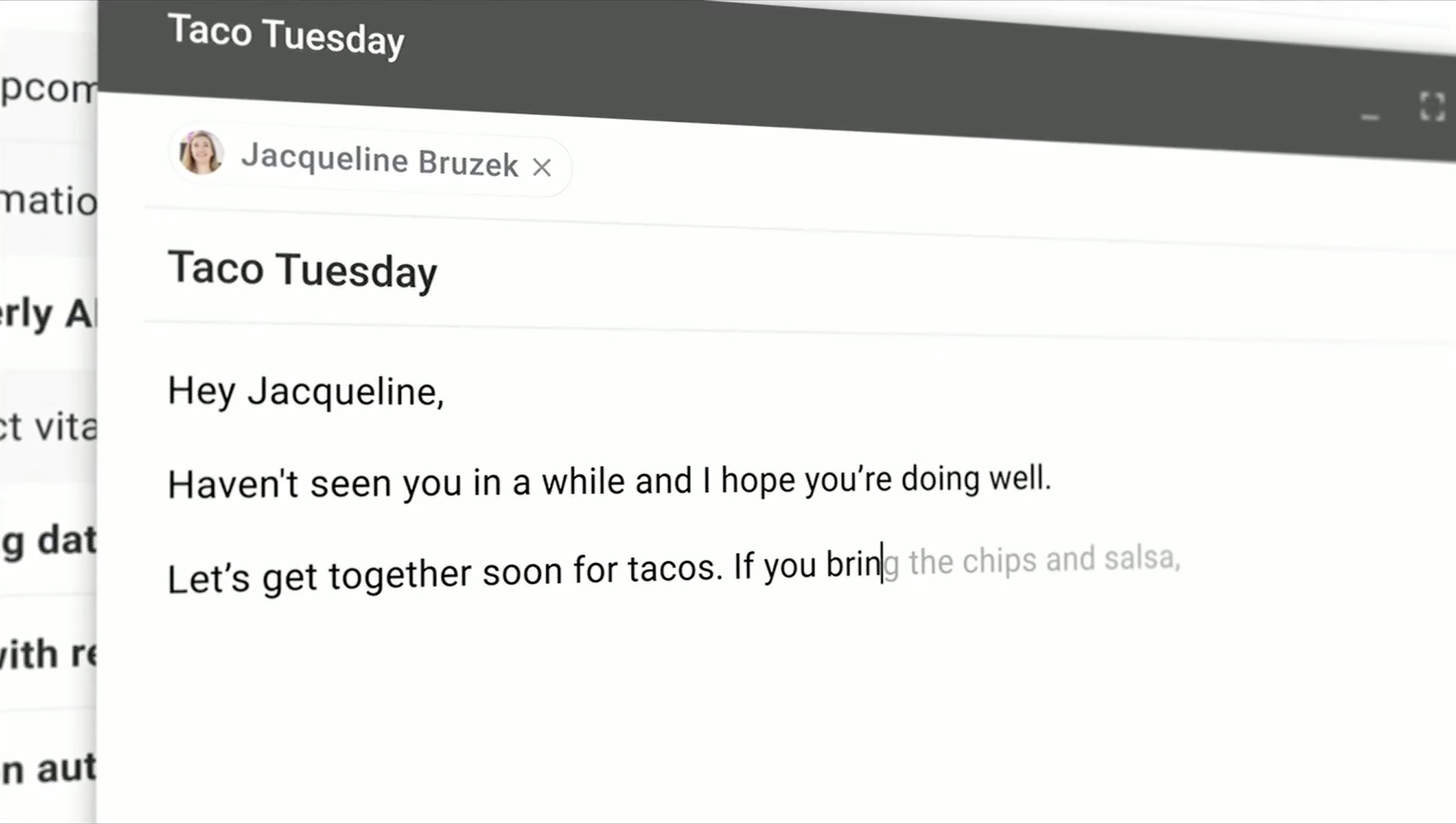

Gmail Smart Compose

Oglądając jak Sundar Pichai pisze maila, w którym Gmail sam proponuje dokańczać zdania – wystarczy nacisnąć Tab – zacząłem się zastanawiać nad tym, na ile taka forma twórczości asystowanej może wpłynąć bezpośrednio na to, co chcemy powiedzieć. Bez problemu jestem w stanie sobie wyobrazić sytuację, w której zaczynam coś pisać, ale Google zaczyna podpowiadać mi co innego, a ja sobie myślę, że tak, to nawet lepszy pomysł. Jak to wpłynie na nas w perspektywie czasu? Czy zauważymy moment, kiedy te automatyczne sugestie zaczną bezpośrednio wpływać na nasz tok myślenia? Czy to będzie można wykorzystać do zmiany naszego punktu widzenia? Czy będzie można manipulować lub sterować nami? To właśnie są te pytania (być może naciągane, ale chodzi mi o zilustrowanie problemu), których mam wrażenie, że Google sobie nie zadaje, jak już wspominałem powyżej.

Google Photos i Lens

W sumie nie zdziwiłem się, że największe zaskoczenie widowni w tej części prezentacji wywołała konwersja zdjęcia dokumentu leżącego na stole do idealnie przyciętego PDF-a. Są programy, które robią to od dawna, również automatycznie, ale nie ukrywam, że integracja z aparatem systemowym jest mile widziana. Szkoda tylko, że nie poszli o krok dalej, umożliwiając automatyczne usunięcie takiego zdjęcia dokumentu i wrzucenie go jako PDF do naszego Google Drive do odpowiedniego katalogu.

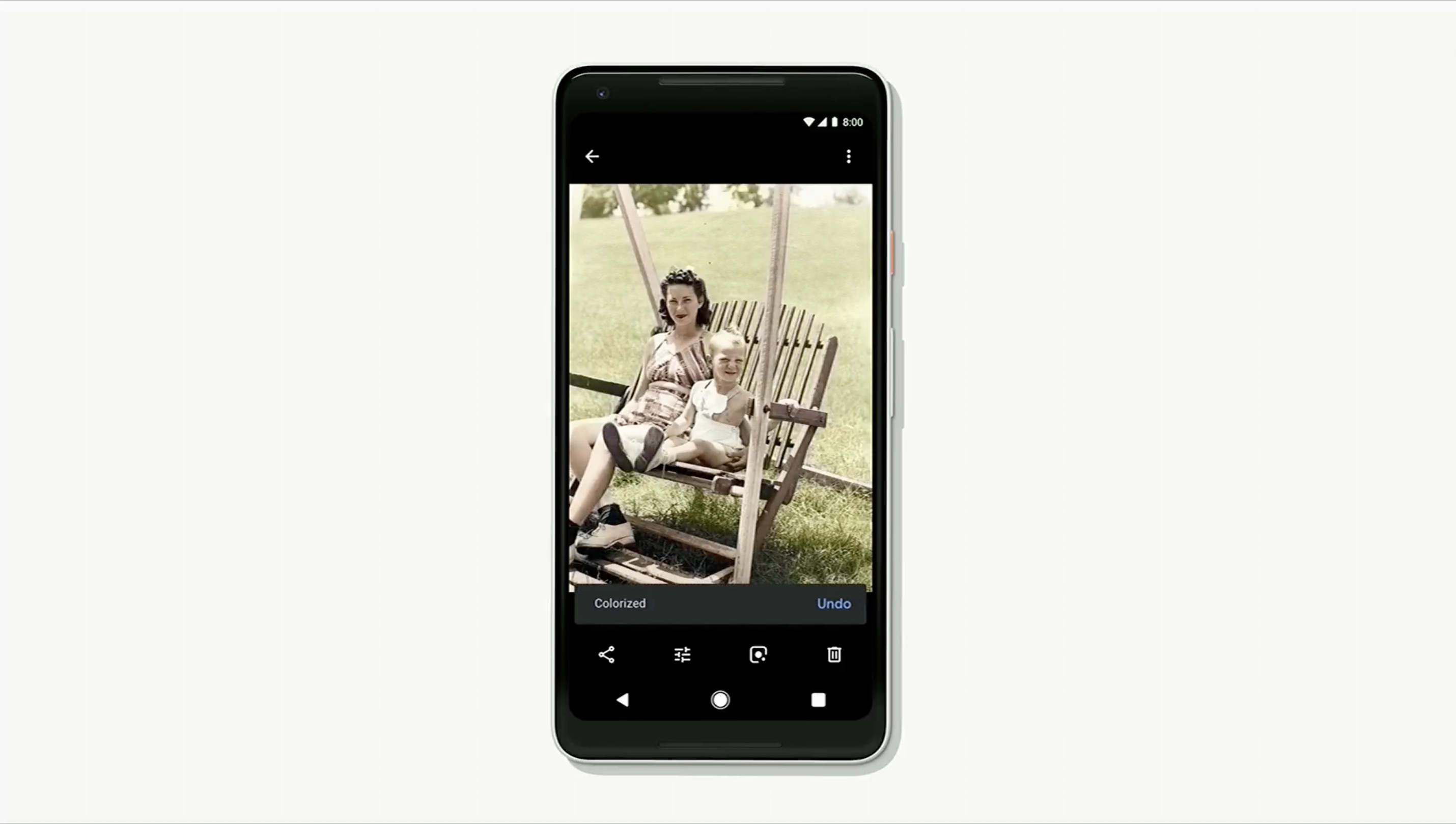

Możliwości Google Photos i Google Lens są coraz większe i imponujące każdego roku. Apple tutaj ewidentnie nie nadąża z Photos, które nie potrafią tak wielu rzeczy, które Google robi za pomocą swojej infrastruktury internetowej. Osobiście najbardziej przypadły mi do gustu Suggested Actions – automatyczne podpowiedzi, które… podpowiadają, żeby na danym zdjęciu (lub ich grupie) coś wykonać. Może to być podzielenie się zdjęciami z imprezy z jej uczestnikami albo dodanie koloru do starego zdjęcia z naszego dzieciństwa. Przykładów pokazano znacznie więcej i wiem, że skorzystałbym z nich, samemu przecież mają pokaźną liczbę zdjęć.

Każdego roku, zaraz po Google I/O, obiecuję sobie, że założę płatne konto w Google Photos i tam wrzucę wszystkie swoje zdjęcia, i przy okazji wykorzystam go jako dodatkowy backup. Każdego roku po paru chwilach entuzjazmu, zdaję sobie sprawę z ceny takiej decyzji – Google zanalizuje wszystkie moje zdjęcia, ich lokalizacje i inne metadane, i będzie miało jeszcze więcej informacji na temat mój, moich podróży i mojej rodziny. Nie jestem jeszcze na to gotowy.

Google Maps

Nie da się ukryć, że Apple Maps w Polsce spisuje się znacznie gorzej niż w USA. Winę częściowo ponosimy za to my, ponieważ mniej użytkowników oznacza mniej zgłaszanych błędów i poprawek, a to oznacza większą niechęć do korzystani z nich. Google Maps i Waze, które należy do Google’a i którego dane są wykorzystywane w Maps, są znacznie bardziej przydatne w naszych warunkach i nie ukrywam, że korzystam z nich regularnie. Jednocześnie całkowicie nie rozumiem dlaczego Maps tak powoli reagują na nagłe korki czy wypadki. Waze zresztą też nie jest idealny, ponieważ raz, po wypadku na autostradzie A2, co skutkowało jej zamknięciem, usilnie prowadził mnie do skrótu, do którego nie można było dojechać. Gdybym akurat w Maps wtedy nie przerwał nawigowania i ponownie go załączył, żeby przeliczył trasę ponownie, to w wpadłbym w ten korek jak śliwka w kompot. Po mieście też nie jest lepiej, a jak już któryś z nich zdecyduje o tym, żeby poprowadzić nas skrótem, to czasami nie rozumie, że nie posiadam Land Rovera Defendera z podniesionym prześwitem, który byłby konieczny do przejazdu proponowaną trasą po bezdrożach. To wszystko stoi w sprzeczności z tym, co Google prezentuje na swoich keynote’ach, które obiecują przyszłość w tej dziedzinie, której nie jestem w stanie tego dostrzec na co dzień.

Jest jednak jedna funkcja Google Maps, które jest bezcenna w codziennym życiu dla mnie. Chodzi o możliwość sprawdzenia godzin otwarcia danego lokalu. Niestety, to jest kłopotliwe szczególnie w święta i nasze nowe niedziele, kiedy to właściciel może indywidualnie decydować o tym, czy wstanie z łóżka tego dnia, czy nie. Wykorzystanie tutaj automatycznego dzwonienia, pokazanego przy okazji demonstracji Google Assistant, do uaktualniania godzin otwarcia, może okazać się genialne, a skorzystają z tego wszyscy, bo wystarczy że zadzwoni danego dnia, np. rano, jeden Google Assistant, a wszyscy inni użytkownicy zobaczą uaktualnione informacje w Google Maps.

Android P

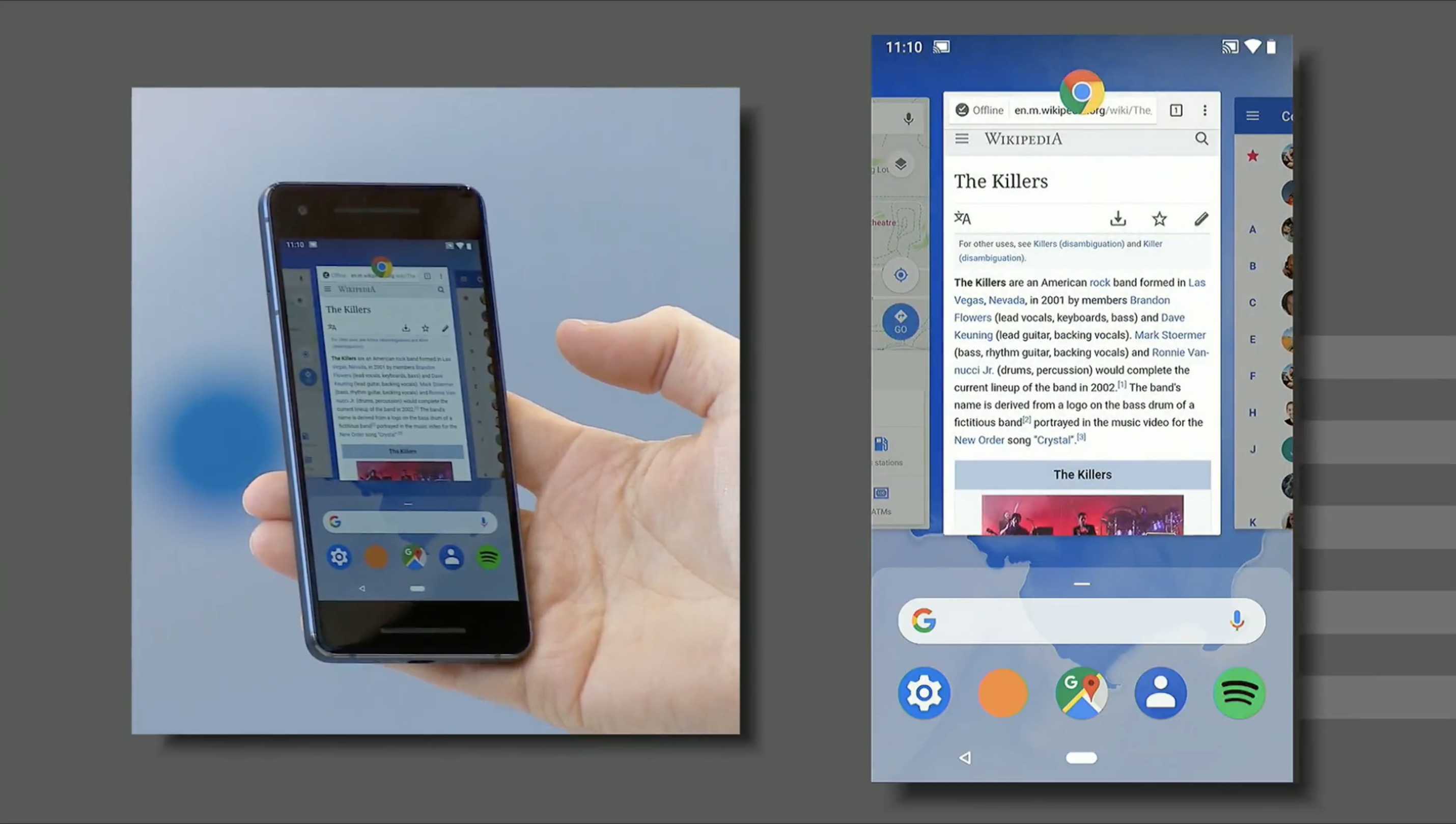

Adopcja gestów znanych z iOS i iPhone’a X1 Palma webOS jest niewątpliwie dobrą decyzją, szczególnie w świetle tak dużych ekranów. Android jednak tutaj pójdzie własną drogą, umożliwiając nieznacznie inne gesty. Dla przykładu, poziome machnięcie na dole ekranu w X-tce powoduje przełączenie się o jedną aplikację wstecz lub wprzód. Android będzie z kolei wykorzystywał ten gest jak pasek do przewijania w historii, zależnie od tego jak daleko przesuniemy palec. Tutaj powstaje konflikt w kwestii tego jak nasz mózg przetwarza dotyk na ekranach smartfonów. Dobrym przykładem będzie jakakolwiek przeglądarka internetowa i przewijanie stron góra/dół – strona „trzyma się” naszego palca i rusza tyle ile on, jeden do jednego. Podobnie jest na iPhone X, gdzie poziome przesunięcie i przytrzymanie dolnego „uchwytu” działa identycznie – jeśli przesuniemy palec o pół ekranu, to zobaczymy na nim pół obecnie otwartej aplikacji i pół poprzedniej. Google jednak łamie to, bo przesuwając palec o 1 centymetr (szacuję, na oko) powoduje przeskok o 1 aplikację, o 2 centymetry 2 aplikacje i tak dalej. Już widziałem raporty osób z bety Androida P, które na to narzekają. Finalnie to beta, więc ciekawy jestem na czym to się dokładnie skończy, bo dalsze zmiany są niewykluczone.

Pozostałe funkcje nie były w jakiś sposób przełomowe, chociaż dosyć oczywiste było podkreślanie przez Google’a ich promowanie „Digital Wellbeing”, czyli dbanie o nasze, również cyfrowe, zdrowie poprzez sugerowanie, żeby iść spać albo podpowiadanie, że już za długo siedzimy na Twitterze. Zastanawiam się na ile spowodowane to jest ostatnią aferą z Facebookiem, gdzie Google ponownie chce się wykreować na firmę, która o nas dba. Nie umknęło też mojej uwadze to, że całość zaczyna naprawdę z nami współpracować tylko wtedy, kiedy dajemy Google dostęp do absolutnie wszystkiego. Dla prostego przykładu, Google Assistant nie będzie funkcjonował prawidłowo, jeśli nie dostanie dostępu do niektórych rzeczy, jak chociażby historii przeglądania stron WWW itp. Jednocześnie, program chce od nas dostępu do m.in.:

- kontaktów,

- kalendarzy,

- alarmów,

- zainstalowanych aplikacji,

- muzyki,

- filmów,

- książek,

- „innych treści”,

- naszej lokalizacji GPS, nawet gdy nie używamy programu,

- informacji czy jesteśmy podłączenie do Wi-Fi czy nie, jakich sieci i na jak długo.

Umówmy się, że GA nie potrzebuje tego wszystkiego, ale bez tego nie będzie prawidłowo działał. Są też sytuacje, w której Asystent po prostu odmówi współpracy i poprosi o danie mu dostępu do danych (których, jak już wspominałem, nie potrzebuje). To jest właśnie największy problem z tym produktem…

Ciekawostką jest to, że beta Androida P dostępna będzie na:

- Essential Phone,

- Nokia 7 Plus,

- Sony Xperia XZ2,

- Xiaomi Mi Mix 2S,

- Vivo X21,

- OnePlus 6,

- Google Pixel and XL,

- Google Pixel 2 and XL2.

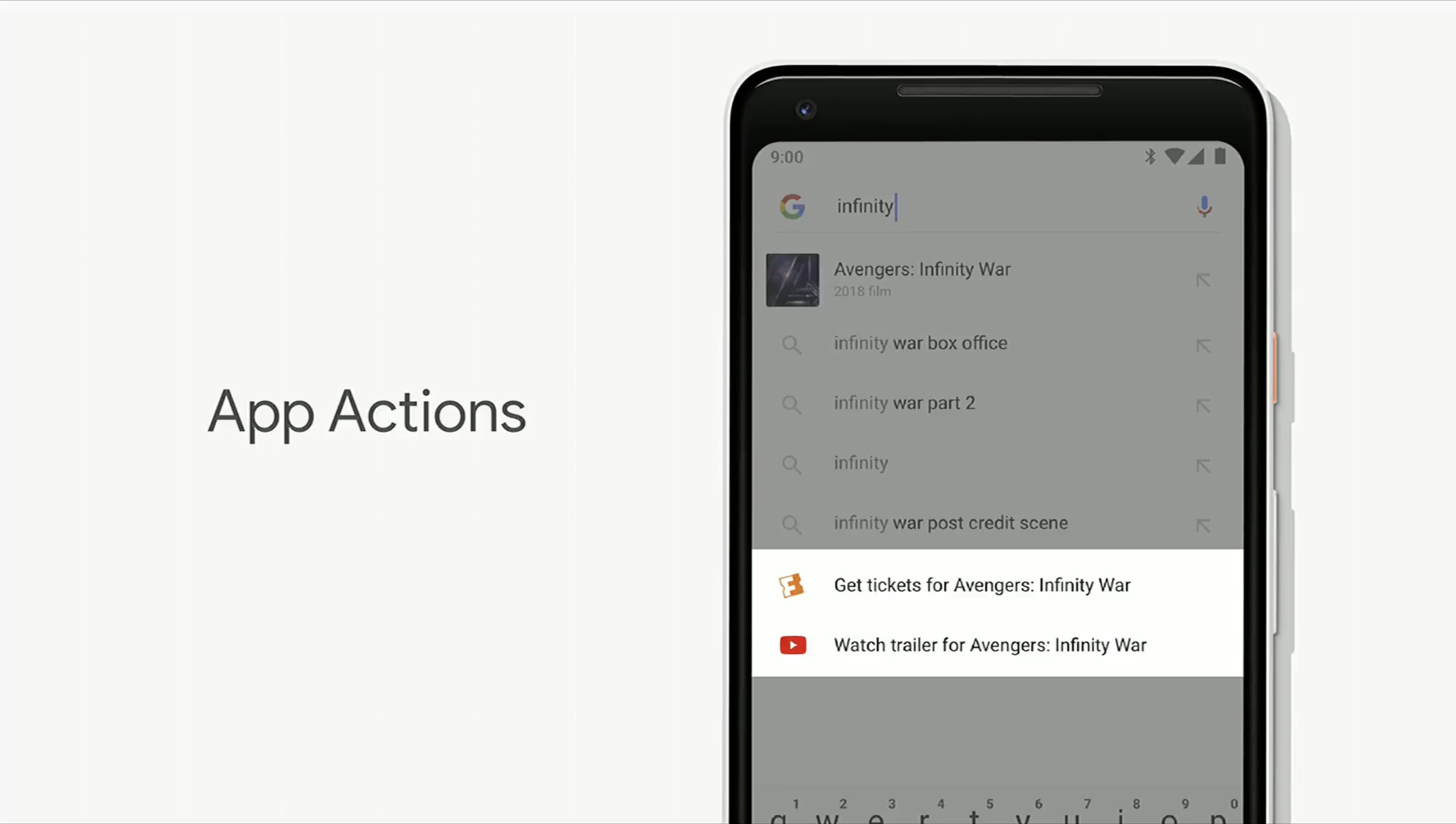

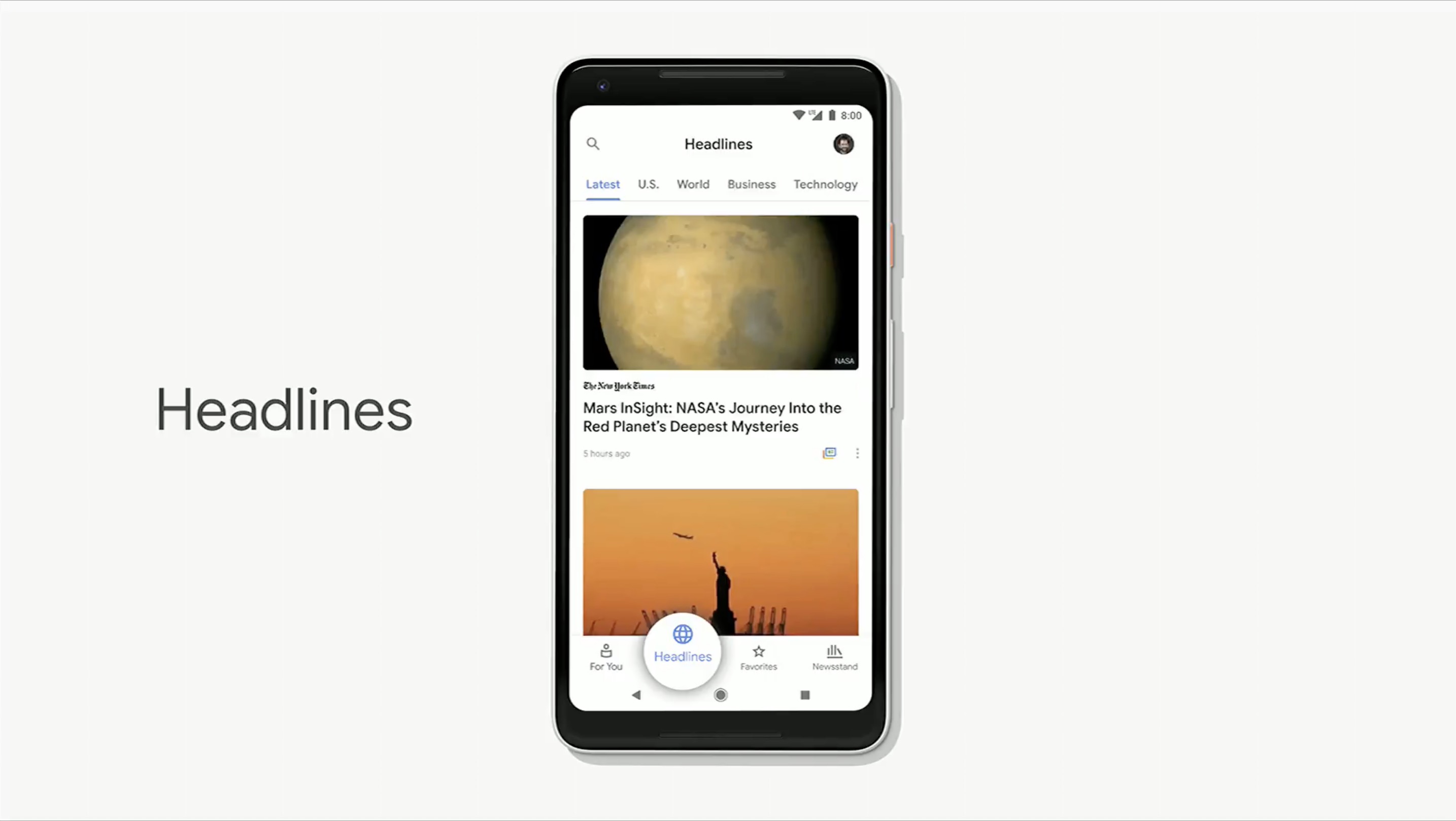

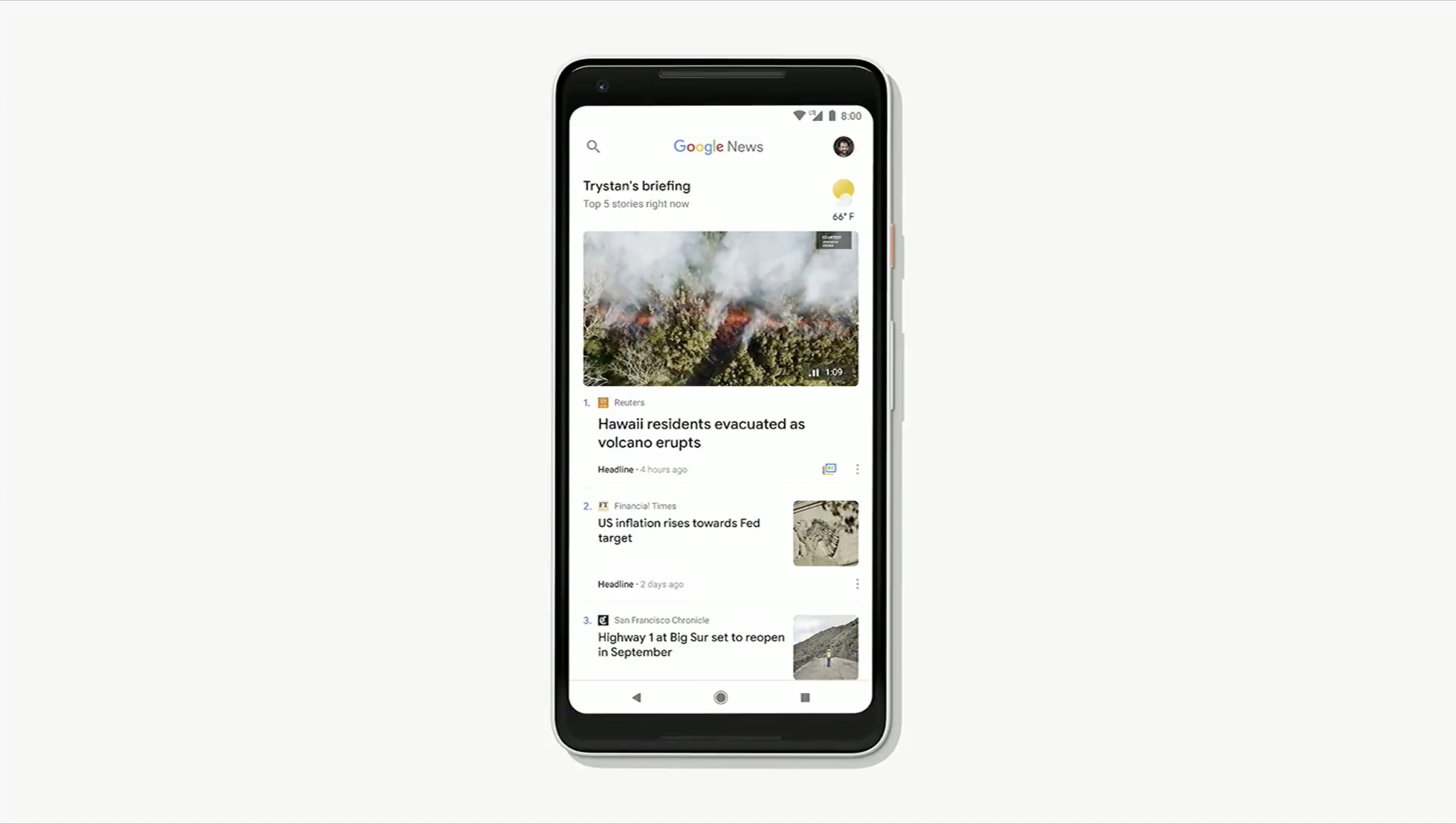

Google News

Podczas gdy Apple News dostępny jest tylko w UK, Australii i USA, pomimo debiutu przed paroma laty, nowy Google News będzie dostępny do końca tygodnia w 127 krajach na świecie, na Androidzie i iOS.

Chyba najciekawszą nowością, przede wszystkim dla amerykanów, jest nowy Subscribe with Google, który umożliwia subskrypcję płatnych treści za pomocą wciśnięcia jednego przycisku. Wykorzystuje do tego dane z naszego konta Google i szkoda jedynie, że firma nie poinformowała, od razu podczas keynote’a, jakie dane wysyła swoim partnerom-wydawcom. Jednocześnie nie wątpię, że całość może spisywać się wzorowo i sam jestem na tyle ciekawy, że siądę do testów, jak tylko pojawi się w App Store.

Prywatność i podsumowanie

Koniec końców, musimy pamiętać jedno – Google’owi przede wszystkim zależy na zebraniu jak najwięcej informacji o nas, aby wykorzystać je do sprzedania jeszcze większej ilości reklam. Mam wrażenie, że ludzie generalnie pogodzili się z tym, żeby dzielić się nimi do spersonalizowanych reklam, a w zamian otrzymywać darmowy produkt. Afera z Cambridge Analytica jednak pokazała, że gdy te same dane, którymi myśleliśmy, że dzielimy się tylko z Facebookiem, są nagle wykorzystywane przez podmioty trzecie, a już tym bardziej w celach politycznych, to ludzie nagle zaczynają rozumieć powagę sytuacji. Dzisiaj większość z nas pewnie sobie myśle „meh, przecież nie było afery z Googlem w roli głównej” i że będą się tym martwili później, bo mają ważniejsze sprawy na głowie.

Problem w tym, że jak już będzie afera, to będzie za późno. Korzystajcie więc świadomie ze wszystkich darmowych produktów, rozumiejąc że taka firma jak Google zarabia na Waszej prywatności bezpośrednio i będzie robiła wszystko, aby zdobyć jak najwięcej informacji na Wasze temat.

Nie poruszyłem wszystkich tematów z keynote’a, bo było ich sporo, więc zachęcam zainteresowanych do obejrzenia całości (keynote zaczyna się od 1:20:06). Szkoda tylko, że Google nie pokazało żadnego nowego hardware’u.

- 😉. ↩

Komentarze: 6

Jeżeli chodzi o zbieranie informacji o nas, to nie łudźmy się że żyjemy w lepszym świecie. Corpo to corpo, google, amazon, apple, microsoft – wszyscy są sobie równi w kwestii inwigilacji nas. Jedni ogarniają lepiej, inni gorzej i widać to w produktach.

Ważne jest żebyśmy byli świadomi tego, że nie ma złotej klatki, w której nas nie inwigilują. Chcesz się schować, korzystaj z systemów z otwartym kodem który przechodzi walidację tysięcy użytkowników. Na PC się da zainstalować sobie takie rozwiązania. Na telefonie też są dostępne do zainstalowania systemy otwarte, bez usług Google. Na mac i na iphonie się nie da :(

Dokładnie tak.

Zgłaszanie poprawek do map było moim zdaniem znacznie łatwiejsze w erze Google Map Maker. Obecnie się pogubiłem i nie bardzo wiem jak takowe zgłaszać.

Zapraszam tutaj.

a wiara nie chce zaplacic pare groszakow wiecej za iPhone (i oczywisce iOS)

Abstrahując od artykułu i odnosząc się do samego fragmentu o Waze, muszę przyznać że z gorszą nawigacją chyba nie miałem do czynienia. Daje radę w mieście ale poza nim jest bezużyteczna. Na trasie która liczy 230km (Poznań-Kościerzyna) proponuje mi 3 drogi od 273-360km wszystkie na około strasznie dziwnymi drogami w tym jedna autostradą (nie jest po drodze, ale powiedzmy, że jestem w stanie to zrozumieć).

Nie jestem idiotą, dlatego testowałem różne ustawienia aplikacji (dużo jeżdżę), ale za każdym razem jest tak samo. Mogę jechać swoją trasą (taka jak np. pokazuje Google Maps czy TomTom) 10x przy użyciu Waze, a on i tak będzie proponował swoje trasy z… kapelusza. Raz mu nawet zaufałem, mówię a co mi tam! Może zna się lepiej. Pojechałem dokładnie tak jak Waze kazał, nadłożyłem 50km i straciłem około godziny czasu.

Dlatego osobiście pozostaje z nawigacją TomTom’a z uwagi na informacje o fotoradarach ew. Google Maps + Yanosik w tle.