Dlaczego Apple porzuciło wprowadzenie CSAM?

Apple opublikowało obszerne wyjaśnienie dotyczące porzucenia w zeszłym roku kontrowersyjnego planu wprowadzenia wykrywania materiałów przedstawiających seksualne wykorzystywanie dzieci (tzw. CSAM) w Zdjęciach iCloud.

Oświadczenie Apple, udostępnione przez Wired, pojawiło się w odpowiedzi na żądanie grupy Heat Initiative zajmującej się bezpieczeństwem dzieci

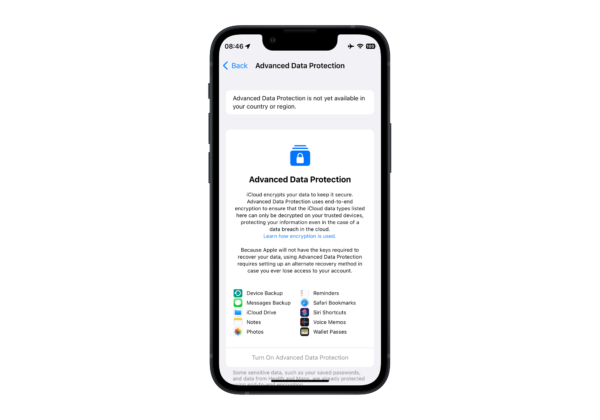

Materiały przedstawiające seksualne wykorzystywanie dzieci są odrażające i jesteśmy zaangażowani w przeciwdziałanie ich udostępnianiu. Skanowanie prywatnie przechowywanych danych iCloud każdego użytkownika stworzyłoby jednak nowe wektory zagrożeń, które złodzieje danych mogliby znaleźć i wykorzystać. Na przykład skanowanie w poszukiwaniu jednego rodzaju treści otwiera drzwi do masowego nadzoru i może wywołać chęć przeszukiwania innych zaszyfrowanych systemów przesyłania wiadomości w różnych typach treści.

– napisał Erik Neuenschwander, dyrektor Apple ds. prywatności użytkowników i bezpieczeństwa dzieci, w odpowiedzi firmy na żądanie Heat Initiative. Dodał jednak, że po współpracy z szeregiem badaczy zajmujących się prywatnością i bezpieczeństwem, grupami zajmującymi się prawami cyfrowymi i obrońcami bezpieczeństwa dzieci, firma doszła do wniosku, że nie może kontynuować opracowywania mechanizmu skanowania CSAM, nawet takiego, który został zbudowany specjalnie w celu ochrony prywatności.

Apple ma pozostać nieugięte także w sprawie Wielkiej Brytanii, gdzie zamierza wycofać usługę iMessage i FaceTime, o ile rząd wprowadzi mechanizmy permanentnej kontroli obywateli.

Rząd Wielkiej Brytanii może zakazać aktualizacji zabezpieczeń Apple