Apple odkrywa na nowo zapomnianą technikę AI do generowania obrazów – Normalizing Flows

Apple zaprezentowało dwa badania, w których reaktywuje mało znaną technikę AI – Normalizing Flows (NF), mogącą konkurować z popularnymi dziś modelami dyfuzyjnymi (np. Stable Diffusion) i autoregresyjnymi (np. GPT-4o).

Czym są Normalizing Flows? To modele, które uczą się przekształcać dane rzeczywiste (np. obrazy) w szum i odwrotnie, z możliwością dokładnego obliczania prawdopodobieństwa wygenerowanego obrazu – coś, czego nie potrafią modele dyfuzyjne.

Pierwsze badanie TarFlow łączy Normalizing Flows z architekturą Transformerów. Generuje obraz bez tokenizacji, operując bezpośrednio na wartościach pikseli. To redukuje utratę jakości typową dla modeli przekształcających obrazy w symbole tekstowe.

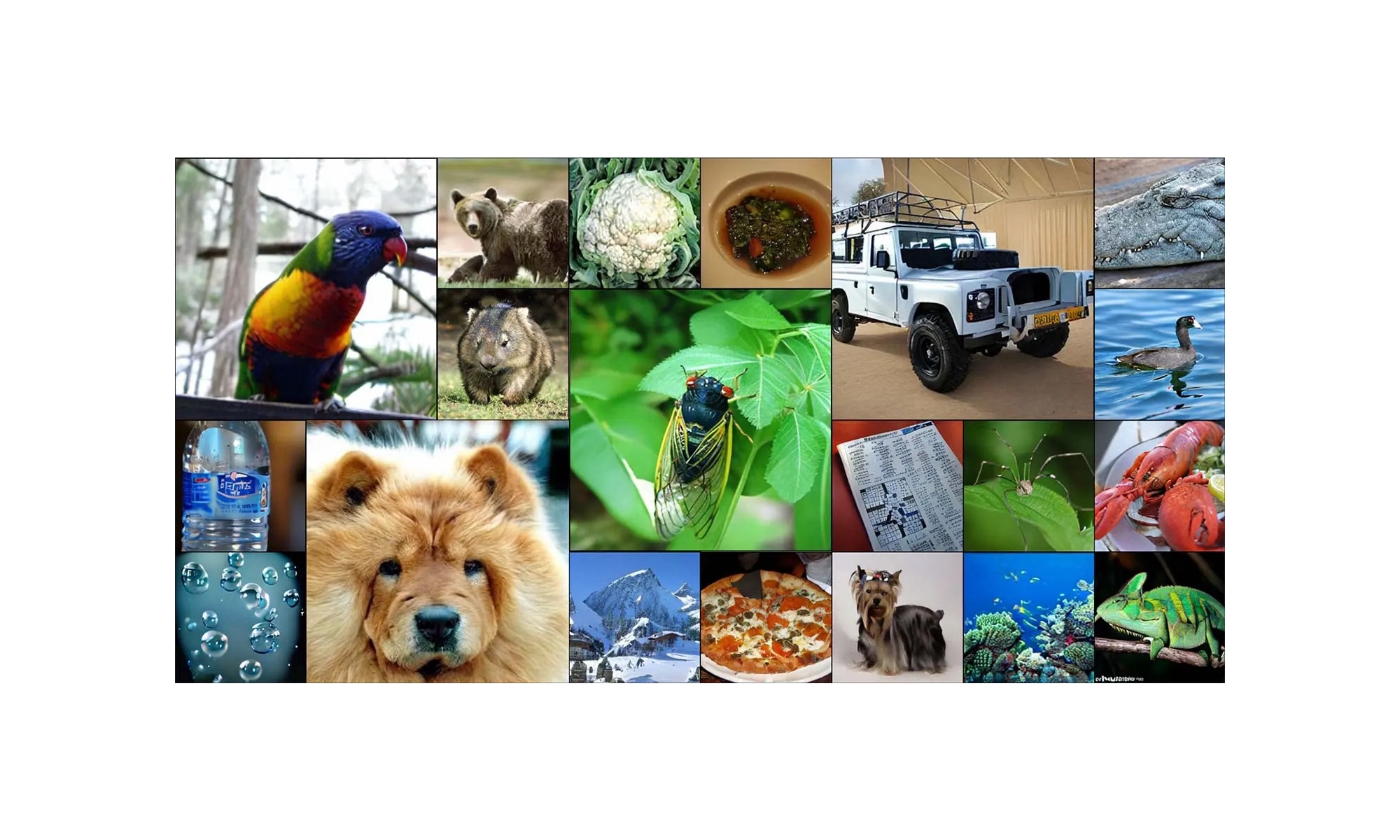

Obrazy o różnych rozdzielczościach wygenerowane przez modele TarFlow. Od lewej do prawej, od góry do dołu: obrazy 256×256 w AFHQ, obrazy 128×128 i 64×64 w ImageNet.

2 badanie STARFlow działa w przestrzeni latentnej – generuje uproszczony obraz, który dekoder przekształca w wysoką rozdzielczość. Model może być zasilany zewnętrznymi LLM-ami (np. Gemma), które interpretują polecenia tekstowe użytkownika, a STARFlow skupia się na szczegółach wizualnych.

Jak wygląda porównanie Apple z OpenAI?

GPT-4o generuje obrazy jako sekwencje tokenów (jak tekst), co daje uniwersalność, ale jest wolne i zasobożerne – wymaga pracy w chmurze.

STARFlow jest zoptymalizowany pod pracę lokalną (on-device) – szybszy i bardziej energooszczędny.

Apple stawia na wydajne, lokalne generowanie obrazów, idealne dla urządzeń mobilnych.