Google I/O 2022 – co pokazało Google?

Google I/O to doroczna konferencja deweloperska organizowana przez doskonale znanego, internetowego potentata. Pierwsza prezentacja, otwierająca konferencję każdego roku, to okazja do zobaczenia nowych produktów Google. Oto co potentat z Mountain View pokazał w tym roku.

Google I/O to konferencja przeznaczona przede wszystkim dla programistów, zatem jeżeli nie kodujecie większość wydarzenia nie będzie dla Was kompletnie interesująca. Jednak wyjątkiem jest wspomniana pierwsza prezentacja – wówczas możemy poznać nowości, które niebawem zostaną wdrożone przez wyszukiwarkowego potentata w wielu powszechnie wykorzystywanych usługach, nie zabrakło również nowych produktów sygnowanych literką G na obudowie.

Jako pierwszy na scenę wyszedł ten, kogo się spodziewaliśmy – Sundar Pichai, CEO Alphabet. Pichai na wstępie pochwalił się dotychczasowymi osiągnięciami Google. Wymienił np. przewidywanie powodzi i ostrzeganie przed nimi za pomocą powiadomień wysyłanych bezpośrednio użytkownikom smartfonów, co jego zdaniem umożliwiło milionom ludzi w Indiach i Bangladeszu odpowiednio wcześnie podjąć ewakuację.

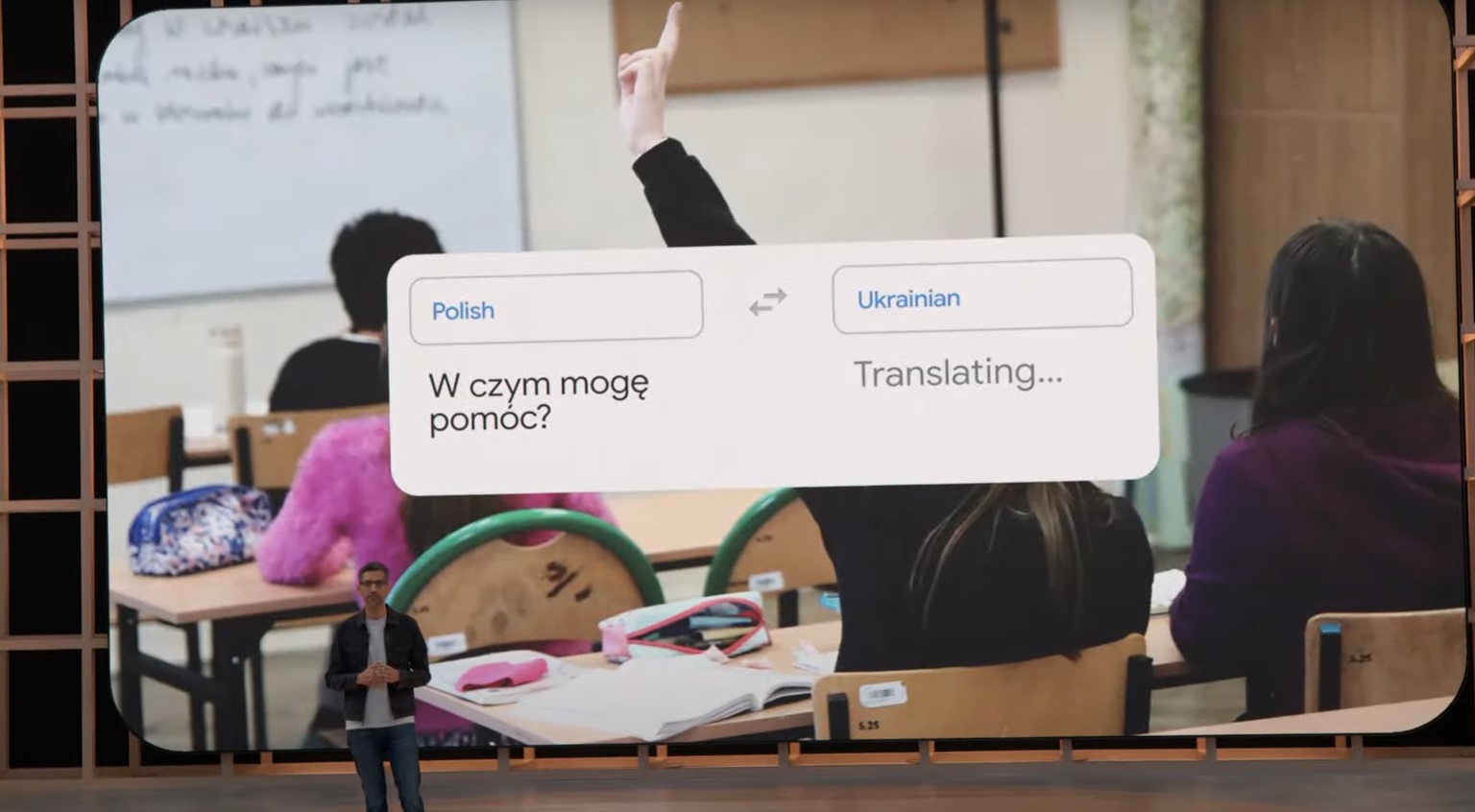

Pichai wspomniał też swoją wizytę w Polsce, w Warszawie, w marcu tego roku. W trakcie trwającej wciąż inwazji rosyjskiej na Ukrainę. Publicznie wyraził podziw dla solidarności Polaków z zaatakowanymi sąsiadami. Podkreślił też, że niemal wszyscy pracownicy polskiego oddziału Alphabet Inc. dobrowolnie wspomogli uchodźców udostępniając im własne domy i mieszkania, dzieląc się przestrzenią życiową. Jego słowa wzbudziły aplauz wśród publiczności na prezentacji. Zdradził też, że Google aktywnie ostrzega wielu mieszkańców Ukrainy przed atakami rakietowymi. Jednak to wszystko już działa, tutaj skupimy się na nowościach, które właśnie wchodzą w życie, bądź niebawem dołączą do bogatej puli usług Google.

Google I/O 2022 – Tłumacz Google i Mapy Google

Nowe języki obsługiwane w usłudze Google Translate (źr. Google I/O)

Popularna usługa Tłumacz Google (Google Translate) wzbogaciła się o „rozumienie” i tłumaczenie nowych 24 języków – tłumaczenie jest możliwe w czasie rzeczywistym na dowolnej platformie, na której działa usługa Google Translate.

W przypadku usługi Google Maps, Pichai pochwalił się, że wizualna baza danych tej usługi zawiera już informacje na temat ponad 1,6 miliarda budynków oraz ponad 60 mln km dróg na całym świecie. Oprócz tego Mapy Google wzbogacone zostały o nowe możliwości wykorzystujące zaawansowane techniki mapowania 3D i algorytmy uczenia maszynowego. Pozwoliło to np. na generowanie przestrzennych wizualizacji wielu miejsc na całym świecie. Nowy tryb pracy usługi został nazwany Immersive View. Przykładowy efekt na ilustracji poniżej:

Centrum Londynu w wygenerowanym widoku Immersive View w Mapach Google (źr. Google I/O)

Ponadto widok Immersive View pozwala turystom poszukującym np. miejsca na obiad wirtualnie „wejść” do konkretnych restauracji i obejrzeć wnętrze w płynnie animowanym i wygenerowanym przez AI na bazie setek zdjęć widoku. Ten fragment prezentacji również wzbudził spory aplauz.

Za pomocą Map Google w trybie Immersive View będzie można wirtualnie obejrzeć wnętrze wielu lokali – nie w formie zdjęć, lecz wygenerowanego wideo (źr. Google I/O)

Funkcja Immersive View będzie działać na każdym smartfonie, na którym jest aplikacja Mapy Google. Aktualizacja ją wprowadzająca ma być opublikowana jeszcze w tym roku. Oczywiście widoki w nowym trybie nie obejmą od razu całego świata, lecz wybrane lokalizacje, ale to i tak robi naprawdę imponujące wrażenie.

Funkcja eco-friendly routing pozwoli wyznaczać trasy, dzięki którym zaoszczędzisz paliwo (źr. Google I/O)

Mapy Google to jednak przede wszystkim nawigacja. W tym zakresie również pojawia się nowa funkcja, którą Pichai nazwał Eco-friendly routing. Chodzi o to, że korzystając z nawigacji Google Maps, będziemy mogli wybrać trasę, która wg sztucznej inteligencji będzie najbardziej ekonomiczna dla naszego pojazdu. Zużyjemy najmniej energii lub paliwa. Ten specjalny tryb wyznaczania tras funkcjonuje już w USA i Kanadzie, ale zgodnie z zapowiedzią szefa Alphabet, jeszcze w tym roku z nowego trybu wyznaczania tras będą mogli skorzystać użytkownicy w Europie. Co ważne – to działa. W Ameryce Północnej w tym trybie pokonano 86 mld mil, co pozwoliło zmniejszyć emisje o pół miliona ton CO2 – to tak, jakby z ruchu wyeliminować ok. 100 tysięcy samochodów. Sytuacja win-win, zwłaszcza przy dzisiejszych cenach paliwa. W podobne rozwiązanie wyposażono także usługę Google Flights (Loty Google), czyli system wyszukiwania i rezerwacji lotów – użytkownicy mogą wybrać trasę, która pozostawi najmniejszy ślad węglowy naszej podróży (choć niekoniecznie będzie najtańsza).

Google I/O 2022 – Zmiany w YouTube i Google Workspace

Zmian doczekał się również YouTube. Wprowadzono m.in. automatyczne tworzenie rozdziałów w filmach publikowanych w tym serwisie, a także możliwość korzystania z transkrypcji tekstowej na platformach mobilnych (zarówno Android jak i Apple iOS) oraz symultaniczne i w pełni automatyczne tłumaczenie napisów w filmach na szesnaście języków. Automatyczne generowanie rozdziałów w filmach na YT ma być znacznie bardziej precyzyjne i w całości realizowane przez sztuczną inteligencję (oczywiście o ile sam twórca nie podzieli własnego materiału na rozdziały).

Kolejną ciekawą funkcją, która pojawi się w Google Workspace jest automatyczne generowanie streszczeń i podsumowań długich dokumentów przez sztuczną inteligencję. Koniec z czytaniem otrzymanego właśnie od szefa 25-stronicowego dokumentu na 5 minut przed ważnym spotkaniem. Nowości w aplikacjach do pracy grupowej jest więcej – Google Chat może automatycznie wyróżniać istotne fragmenty rozmów, a w Google Meet sztuczna inteligencja automatycznie stworzy transkrypcję z podsumowaniem spotkania dla uczestników.

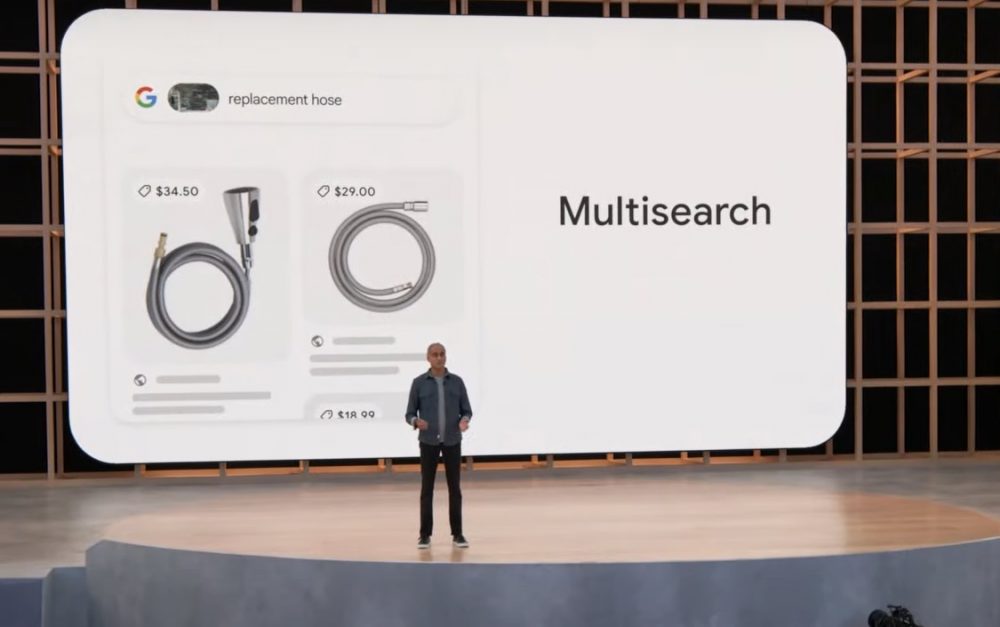

Funkcja Multisearch w wyszukiwarce Google pozwala wyszukiwać jednocześnie frazą i obrazem (źr. Google I/O)

Wyszukiwarka to DNA Google. Zwykle tę usługę kojarzymy przede wszystkim z wyszukiwaniem danych online, każdy to wie. Google potrafi już więcej. Usługa Google Search otrzymała już funkcję Multisearch, który pozwoli poszukiwać informacji jednocześnie na kilka sposobów. Powyższe zdjęcie jest tego przykładem. Załóżmy, że popsuł Ci się kran w kuchni. Robisz mu zdjęcie i piszesz „potrzebuję zamiennika” – Google w wynikach wyświetli stosowne produkty. Jeżeli do frazy dodasz „blisko” – Google zaproponuje sklepy z odpowiednim sprzętem w jak najbliższej lokalizacji. Multisearch z lokalizacją w angielskiej wersji Google Search pojawi się jeszcze w tym roku, ale rozwiązanie to sukcesywnie będzie trafiać także do użytkowników posługujących się innymi językami.

Funkcja Scene Exploration pozwoli wybrać wysoko oceniany produkt w grupie podobnych (źr. Google I/O)

Podczas prezentacji zademonstrowano też działanie funkcji Scene Exploration. Jak to działa? Załóżmy, że jesteśmy w sklepie i poszukujemy prezentu – czekolady. Problem w tym, że nie jesteśmy specjalistami od czekolady, wiemy tylko że ma to być ciemna czekolada i bez orzechów. Problem? Od czego smartfon z Google? Wystarczy, że wpiszemy kryteria (ciemna, bez orzechów), uruchomimy Google Lens i skierujemy obiektyw smartfonu na ladę wyłożoną dziesiątkami rodzajów czekolad – Google przeanalizuje obraz i po chwili podświetli w kadrze produkty najlepiej oceniane przez internetowych łasuchów i spełniające podane kryteria – genialne.

Bardziej naturalne interakcje z Asystentem Google

Nie trzeba będzie już mówić Hey Google. Wystarczy, że popatrzysz na urządzenie z asystentem i… zaczniesz zadawać pytanie. Asystent za pomocą kamer urządzenia na którym działa, analizuje gdzie kierujesz wzrok, czyta z ust, analizuje mimikę itp. Na prezentacji pokazano taki sposób interakcji z Asystentem Google za pomocą urządzenia Google Nest Hub Max. W przypadku urządzeń smarthome współpracujących z centralką Google Nest Hub, Asystent rozumie też szereg fraz, które nie wymagają wywołania, lecz zostaną po prostu od razu wykonane. Jakie frazy? Np. w stylu „zgaś światło w salonie”.

Asystent Google nauczył się również rozpoznawać niepełne zapytania (źr. Google I/O)

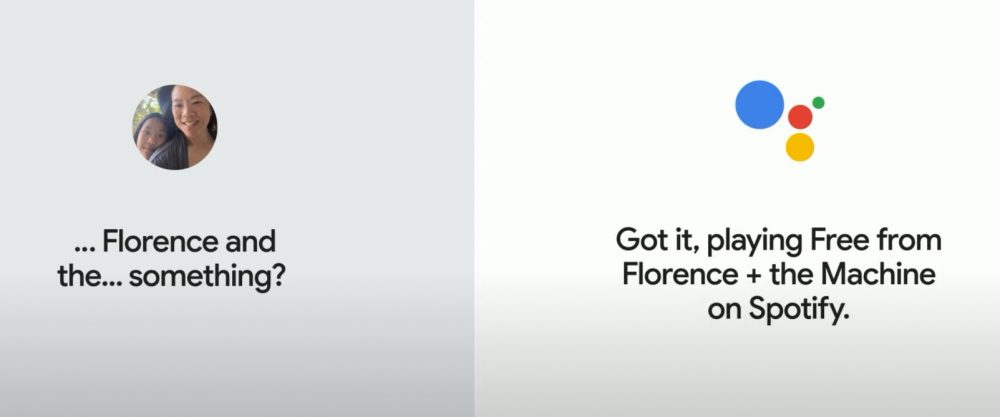

Asystent nauczył się też reagować na niepełne zapytania, np. gdy zapytasz by odtworzył Ci piosenkę, której tytułu nie pamiętasz, ale coś tam Ci się kojarzy (i podasz co), to już ta fragmentaryczna wypowiedź może wystarczyć do odnalezienia właściwego utworu i odtworzenia go w wybranym serwisie/aplikacji (np. Spotify). Oczywiście w pierwszej kolejności nowe zdolności Asystenta Google trafią do wersji anglojęzycznej – z czasem do pozostałych wersji językowych.

Przy okazji zdolności konwersacyjnych algorytmów Google pokazano też wstępne możliwości nowej, konwersacyjnej sztucznej inteligencji LaMDA 2. Rozwiązanie to jeszcze nie jest gotowe do wdrożenia publicznego, ale przedsmak możliwości tej AI ujawniła demonstracja będąca odpowiedzią zadane przez prezentera zapytanie „Chcę posadzić ogród warzywny„. Co zrobiła AI? Nie wyszukała strony dla ogrodników, czy sklepu ogrodniczego, lecz wygenerowała kompletną listę działań, krok po kroku, jakie należy podjąć by uzyskać pożądany cel. Fragment dotyczący LaMDA 2 możecie obejrzeć na poniższym wideo:

Google I/O 2022 – Bezpieczeństwo od Google

Google zamierza zainwestować w cyberbezpieczeństwo 10 mld dolarów (źr. Google I/O)

Znaczną część prezentacji otwierającej tegoroczną konferencję Google I/O zajęły kwestie dotyczące cyberbezpieczeństwa. Firma ogłosiła, że zamierza zainwestować 10 mld dolarów w modernizację systemów pod kątem bezpieczeństwa danych, jak również wyszkoli armię specjalistów ds. cyberbezpieczeństwa. Jednocześnie przedstawiciele Google’a podkreślali, że większość (90 proc.) ataków dziś przeprowadzanych do phishing. Algorytmy AI opracowane przez Google będą zatem chronić użytkowników poprzez wyłapywanie tego typu ataków jeszcze zanim np. treść maila phishingowego trafi do skrzynki potencjalnej ofiary. Chronione przed atakami tego typu mają być również treści przetwarzane w ramach Google Workspace, czyli dokumenty, arkusze, prezentacje itp.

Ponieważ motywacją cyberprzestępców są przede wszystkim pieniądze, Google ogłosiło również wprowadzenie nowego, cyfrowego portfela Google Wallet. Usługa działająca na sprzęcie mobilnym (smartfony, smartwatche itp.) ma umożliwić nie tylko bezpieczną realizację płatności, ale również przechowywanie wrażliwych danych takich jak bilety lotnicze, poświadczenia szczepień, dane medyczne, prawo jazdy (w USA). Co ważne, Google Wallet ma również chronić dane kart płatniczych zintegrowanych z aplikacją poprzez generowanie wirtualnych numerów kart. Celem jest ukrycie faktycznych danych kart płatniczych przed potencjalnymi agresorami. Google współpracuje w tym zakresie z Visa, Mastercard, American Express i innymi sieciami płatności cyfrowych. Na prezentacji przypomniano również o idei uwierzytelniania w ogóle bez hasła, czyli o standardzie FIDO, o którym już u nas pisaliśmy.

Sprzęt od Google

Google Pixel 6a – najtańszy smartfon z chipsetem Google Tensor (źr. Google I/O)

Na koniec kilka słów na temat nowego sprzętu sygnowanego literką G na obudowie. Do obecnych już na rynku od jesieni ubiegłego roku smartfonów Google Pixel 6 i Pixel 6 Pro dołącza tańsza wersja: Google Pixel 6a, wyceniona na kwotę od 449 dolarów i również wyposażona w SoC Google Tensor. Sprzedaż na rynku amerykańskim ma ruszyć od 21 czerwca. Dla porównania topowy, aktualny smartfon Google’a – model Pixel 6 Pro – można kupić w Polsce za ok. 4200 zł. Uzupełnieniem do smartfonów Google’a są zapowiedziane na konferencji słuchawki Pixel Buds i Pixel Buds Pro (te drugie z ANC, czyli aktywnym tłumieniem dźwięków otoczenia). Pixel Buds Pro mają kosztować 199 dolarów.

Zapowiedziano również nową generację serii Pixel, dwa modele: Pixel 7 i Pixel 7 Pro z chipsetem Google Tensor nowej generacji, Androidem 13 – oba smartfony mają zadebiutować na jesieni 2022 roku. Ich ceny, ani dokładnych parametrów jeszcze nie ujawniono. Jesienią pojawi się na rynku także pierwszy smartwatch Google’a: Pixel Watch z monitoringiem snu, pulsometrem, analizą kondycji, integracją z FitBit itp., działający oczywiście pod kontrolą systemu Wear OS. Ostatnią z zapowiedzianych nowości sprzętowych jest również urządzenie, którego wcześniej nie było w portfolio Google’a – Pixel Tablet. Ten jednak wejdzie na rynek dopiero w 2023 roku.

Na koniec petarda, Sundar Pichai ujawnił nad czym pracuje teraz Google. To okulary z rozszerzoną rzeczywistością wyświetlające Ci treść tego, co mówi Twój rozmówca posługujący się nieznanym Ci językiem. Ba, nawet nie musi mówić, bo okulary „rozumieją” też język migowy. Fragment prezentacji dotyczącej tych okularów, jak i całe Keynote z tegorocznego Google I/O możecie obejrzeć na poniższym wideo: